- Look!👀我们的大模型商业化落地产品

- 📖更多AI资讯请👉🏾关注

- Free三天集训营助教在线为您火热答疑👩🏼🏫

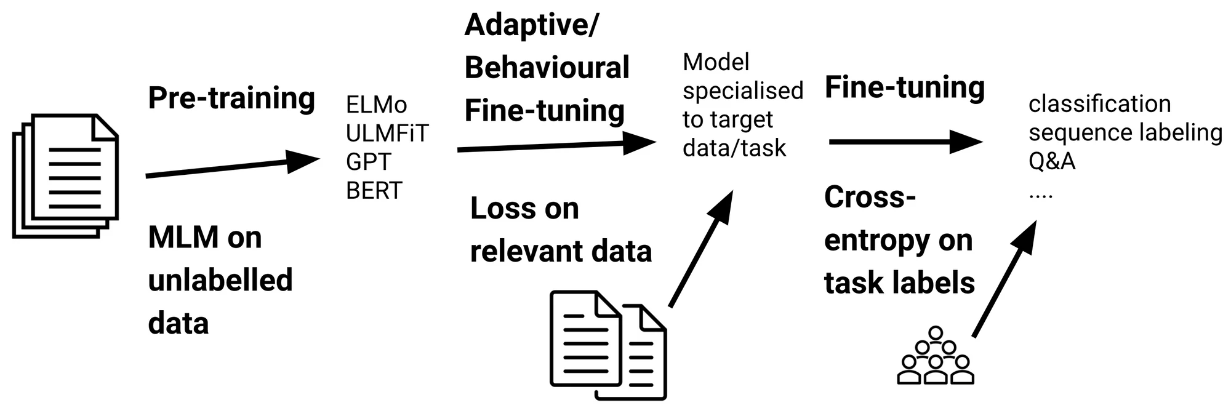

选择合适的预训练模型:

从预训练的BERT模型开始,例如Google 提供的BERT-base 或 BERT-large。这些模型已经在大量文本数据上进行过预训练了,我们如何对BERT模型进行fine-tuning呢?

选择合适的预训练模型:

从预训练的BERT模型开始,例如Google 提供的BERT-base 或 BERT-large。这些模型已经在大量文本数据上进行过预训练了,我们如何对BERT模型进行fine-tuning呢?

准备和预处理数据: 集针对特定任务的数据集。例如,情感分析任务的数据集通常包含文本和对应的情感标签。 将数据分成训练集、验证集和测试集。 使用 BERT 提供的 tokenizer 将文本转换为 token ids。同时生成 attention masks 和 token type ids,这些是 BERT 模型所需的输入格式。

#训练集(training set):训练集是用来训练模型的数据集。在训练阶段,模型尝试学习数据的模式和特征,不断调整和优化其内部参数。 #验证集(Validation Set):验证集用于在训练过程中评估模型的性能,但它不参与训练过程。验证集提供了模型在未知数据上表现的即时反馈。 #测试集(Test Set):测试集是在整个训练和验证过程之后,用来评估模型最终性能的数据集。测试集应该完全独立于训练和验证过程,代表模型在实际应用中可能遇到的数据。 #tokenizer(分词器):Tokenizer是一种工具或程序,用于将文本分割成更小的单元,通常称为tokens。在NLP中,tokens通常是单词、子词或字符。 #Token IDs(Token标识符):Token IDs是tokens经过tokenizer处理后,映射到一个预定义词汇表(vocabulary)中对应的数值标识符。每个token ID是词汇表中唯一对应一个特定token的数字。

自定义模型结构(可选):

在 BERT 的基础上自定义网络结构。通常,我们在 BERT 的最后一层加一个全连接层作为分类层。 确定分类层的输出维度,对于二分类任务,输出维度为 2;对于多分类任务,输出维度为类别数。

加载预训练模型并进行配置: 加载预训练的 BERT 模型,并附加自定义的分类层。 根据任务需求配置模型参数,例如学习率、损失函数和优化器。在 fine-tuning 阶段,通常使用较小的学习率,以防止预训练参数过度调整。

Fine-tuning: 使用训练集对模型进行 fine-tuning。监控验证集上的性能,以进行早期停止或保存最佳模型。 一般来说,BERT 的 fine-tuning 不需要太多的 epoch。根据数据大小和模型复杂度,通常 2-4 个 epoch 就足够了。

模型评估: 在测试集上评估 fine-tuned 的模型性能。使用适当的评估指标,如准确率、F1 分数或混淆矩阵等,来衡量模型在特定任务上的表现。

模型调优与错误分析: 根据模型在测试集上的表现进行调优。可能包括调整模型结构、学习率或数据预处理的方法。 进行错误分析,了解模型在哪些类型的样本上表现不佳,进一步优化模型或数据。

模型部署与应用: 将训练好的模型部署到实际应用环境中。确保模型可以接收实际应用中的输入数据,并能返回预期的输出。

想要了解更多fine-tuning的相关知识,我们近屿智能OJAC推出的《AIGC星辰大海:大模型工程师和产品专家深度训练营》就是学习这部分知识的最好选择。我们的课程是一场结合了线上与线下的双轨合流式学习体验。

除此之外,1月31日晚上8:30,由哈尔滨工业大学的杰出博士毕业生及前之江实验室高级研究专员张立赛博士主讲,近屿智能OJAC将举办一场关于GPT Store的技术更新讲座。

在这场深入的技术研讨中,我们将从GPT Store的基础原理出发,逐步揭开其在现代AI技术领域中的核心作用及其对未来的影响。本次讲座将深度分析GPT Store内部的流行应用,揭示其成功的关键驱动力。我们将详细讨论从Assistant API到GPT Builder的广泛功能,使您对其独特优势和实际运用有全面而深入的了解。

技术深度将是本次讲座的亮点。我们将详尽阐释Finetune的概念、功能及其与GPT Store的紧密关联,并对RAG的概念、功能进行详细解析,探索其与GPT Store的差异,进一步理解GPT Store的核心技术。

此外,讲座将深入剖析GPT Store的商业模式,分析openai如何实现商业成功,同时分析gpt store的市场价值、面临的挑战等关键议题。我们还将比较GPT Store与国内领先的AI模型,如清华大学的GLM4,评估它们的优势和潜在合作机会,以及GPT Store对AI产业未来发展的深远影响。