ceph集群搭建

ceph组件介绍

- MON(monitor)

Monitor在Ceph集群中扮演者管理者的角色,维护了整个集群的状态,是Ceph集群中最重要的组件。Mon保证集群的相关组件在同一时刻能够达成一致,相当于集群的领导层,负责收集、更新和发布集群信息。为了规避单点故障,在实际的Ceph部署环境中会部署多个Mon,同样会引来多个Mon之前如何协同工作的问题。在一个标准的Ceph环境中。 - OSD

实际存储数据的进程。通常一个OSD daemon绑定一个物理磁盘。Client write/read数据最终都会走到OSD去执行write/read操作。 - RADOS(Reliable Autonomic Distributed Object Store, RADOS)

RADOS是Ceph存储集群的基础。Ceph中的一切都以对象的形式存储,而RADOS就负责存储这些对象,而不考虑它们的数据类型。RADOS层确保数据一致性和可靠性。对于数据一致性,它执行数据复制、故障检测和恢复。还包括数据在集群节点间的recovery。 - Librados

简化访问RADOS的一种方法,目前支持PHP、Ruby、Java、Python、C和C++语言。它提供了Ceph存储集群的一个本地接口RADOS,并且是其他服务(如RBD 、RGW) 的基础,以及为CephFS提供POSIX接口。librados API支持直接访问RADOS,使得开发者能够创建自己的接口来访问Ceph集群存储。 - RBD

Ceph块设备。对外提供块存储。可以像磁盘一样被映射、格式化已经挂载到服务器上。支持snapshot(快照)及增量备份。 - RGW

Ceph对象网关,提供了一个兼容S3和Swift的restful API接口。RGW还支持多租户和Openstack的keyston身份验证服务。 - MDS

Ceph元数据服务器,跟踪文件层次结构并存储只供CephFS使用的元数据。Ceph块设备和RADOS网关不需要元数据。MDS不直接给client提供数据服务。

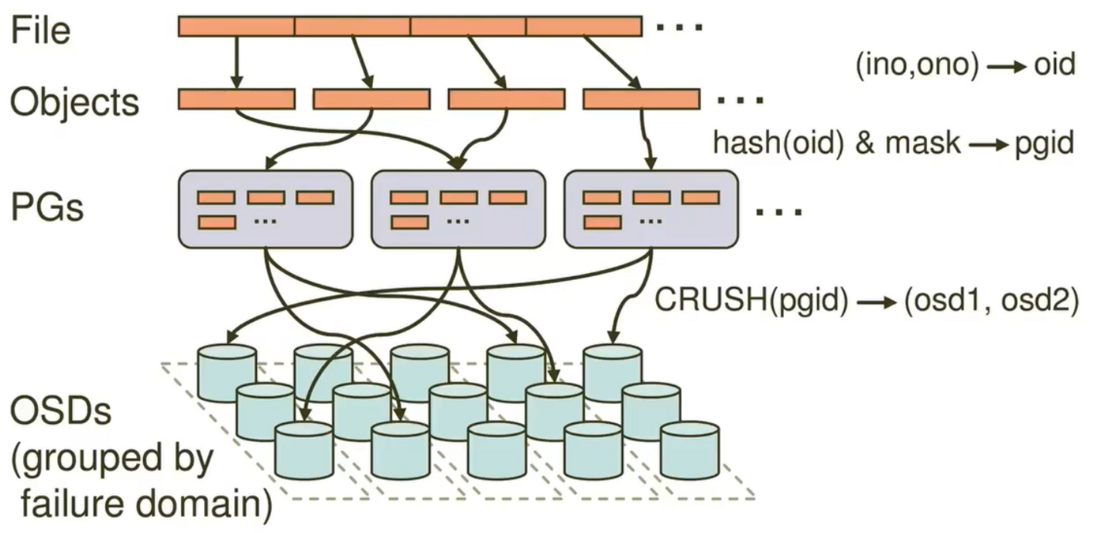

ceph写入数据流程

如下图所示一个File首先被切割为多个objects,每个objects默认4M大小,也就是100M的数据会被切割为25个object,并且每个object都有自己的objectid,通过hash然后进行掩码的运算,确认object是应该分布那个pg中,然后pg通过crush算法,将数据落在不同的osd.默认的crush算法基于host的.

部署ceph集群

使用三台服务器

| 服务器 | 用途 |

|---|---|

| 192.168.21.101 | node-1 |

| 192.168.21.101 | node-2 |

| 192.168.21.102 | node-3 |

修改三台服务器hostname

hostnamectl set-hostname node-1

hostnamectl set-hostname node-2

hostnamectl set-hostname node-3开启ssh免密登录

ssh-keygen

ssh-copy-id -i /root/.ssh/id_rsa.pub node-2

ssh-copy-id -i /root/.ssh/id_rsa.pub node-3关闭所有节点selinux和firewalld

setenforce 0

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

systemctl stop firewalld所有节点安装ntp

yum install ntp ntpdate ntp-doc

systemctl start ntpd && systemctl enable ntpd

ntpq -np所有节点添加yum源

wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

cat >/etc/yum.repos.d/ceph.repo <<EOF

[norch]

name=norch

baseurl=https://mirrors.aliyun.com/ceph/rpm-nautilus/el7/noarch/

enabled=1

gpgcheck=0

[x86_64]

name=x86_64

baseurl=https://mirrors.aliyun.com/ceph/rpm-nautilus/el7/x86_64/

enabled=1

gpgcheck=0

EOF安装ceph初始化mon

yum clean all && yum makecache

yum install python-setuptools ceph-deploy -y

mkdir ceph-deploy && cd ceph-deploy

ceph-deploy new --public-network 192.168.21.0/0 --cluster-network 192.168.21.0/0 node-1

yum install ceph ceph-mon ceph-mgr ceph-radosgw cepht-mds -y #所有节点安装

ceph-deploy mon create-initial #初始化mon

ceph-deploy admin node-1 node-2 node-3 #推送配置文件到各个节点

ceph-deploy mgr create node-1 #初始化mgr作为监控

ceph -s # 查看集群状态扩展mon添加osd

#集群添加osd

ceph-deploy osd create node-1 --data /dev/sdb

ceph-deploy osd create node-2 --data /dev/sdb

ceph-deploy osd create node-3 --data /dev/sdb

#添加mon节点使其高可用

ceph-deploy --overwrite mon add node-2

ceph-deploy --overwrite mon add node-3

#查看osd状态

ceph osd tree

#检查Ceph monitor仲裁状态

ceph quorum_status --format json-pretty