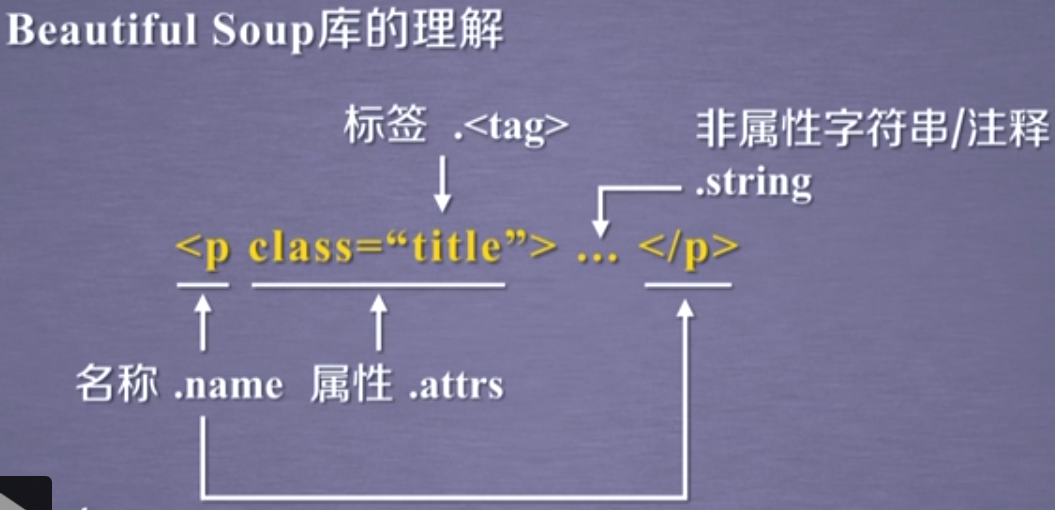

Python爬虫应用领域广泛,并且在数据爬取领域处于霸主位置,并且拥有很多性能好的框架,像Scrapy、Request、BeautifuSoap、urlib等框架可以实现爬行自如的功能,只要有能爬取的数据,Python爬虫均可实现。数据信息采集离不开Python爬虫,而python爬虫离不开代理ip,他们的结合可以做的事情很多,如广告营销、各种数据采集大数据分析,人工智能等,特别是在数据的抓取方面可以产生的作用巨大。 既然爬虫代理ip是python网络爬虫不可缺少的部分,那高质量的,ip资源丰富遍布全国的,高匿极速稳定http代理,非常适合python网络爬虫运用场景。比如在有优质代理IP的前提下使用python实现百度网页采集,增加多线程处理,同时对百度返回的内容进行分类统计,实现代码如下:

import aiohttp

import threading

from collections import Counter

# 定义一个全局变量,用于存储分类结果

categories = Counter()

# 定义一个函数,用于根据文本内容进行分类

def classify(text):

# 这里可以使用任何文本分类的方法,例如正则表达式、机器学习等

# 这里为了简单起见,只使用了简单的字符串匹配

if "Python" in text:

return "Python"

elif "Java" in text:

return "Java"

elif "C++" in text:

return "C++"

else:

return "Other"

async def fetch_page(url, proxy):

# 创建一个 aiohttp 的 ClientSession 对象,并指定代理IP和端口

async with aiohttp.ClientSession(proxy=proxy) as session:

# 使用 session.get 方法发送请求,并获取响应对象

async with session.get(url) as response:

# 返回响应的文本内容

return await response.text()

async def main():

urls = ["https://www.baidu.com/s?wd=" + str(i) for i in range(10)] # 生成十个百度搜索网址

# 假设有一个文件 16yun.txt,每行存储一个代理host和端口,例如 www.16yun.cn:3333

# 读取文件中的所有代理,并存储在一个列表中

with open("16yun.txt") as f:

proxies = [line.strip() for line in f]

tasks = [] # 创建一个空列表,用于存储 task 对象

# 遍历 urls 和 proxies 列表,为每个 url 配对一个 proxy,并创建 task 对象

for url, proxy in zip(urls, proxies):

task = asyncio.create_task(fetch_page(url, proxy))

tasks.append(task)

results = await asyncio.gather(*tasks) # 同时运行所有 task 并获取结果

# 创建一个线程池,用于执行分类任务

pool = threading.ThreadPoolExecutor(max_workers=4)

for result in results:

print(result[:100]) # 打印每个网页的前 100 个字符

# 使用线程池提交一个分类任务,并更新全局变量 categories

category = pool.submit(classify, result).result()

categories[category] += 1

# 关闭线程池并等待所有任务完成

pool.shutdown(wait=True)

# 打印最终的分类结果

print(categories)

asyncio.run(main()) # 运行主协程通过上面的代码实现数据抓取后,我们也可以简单的根据数据来分析下代理ip池要求。 通过获取的数据量,能够大概了解需要访问多少网页,通过目标网站的反爬策略,能大概知道需要多少代理ip,需要多大的代理ip池。假设要访问50万个页面,每个ip能访40个页面后会触发反爬机制,那大概需要1万左右不重复的代理ip。这只是简单的一个计算,网站不同,反爬机制不同,对IP的需求是要以实际测试的数据为准的。在我们使用代理ip时,如何使爬虫更有效的进行,在爬虫采集数据信息需要注意哪些地方,我们一起来分析如何更有效的采集到数据信息,提高工作效率,下一次分享给大家参考。