01

前言

上篇文章我们爬取了今日头条街拍美图,心情相当愉悦,今天这篇文章我们使用Selenium来爬取当当网的畅销图书排行。正所谓书中自有黄金屋,书中自有颜如玉,我们通过读书学习来提高自身的才华,自然能有荣华富贵,也自然少不了漂亮小姐姐。

02

准备工作

在爬取数据前,我们需要安装Selenium库以及Chrome浏览器,并配置好ChromeDriver。

03

Selenium

Selenium是一个自动化测试工具,利用它可以驱动浏览器执行特定的动作,如点击、下拉等操作,同时还可以获得浏览器当前呈现的页面的源代码,做到可见即可爬。对于一些JavaScript动态渲染的页面来说,这种爬取方式非常有效。

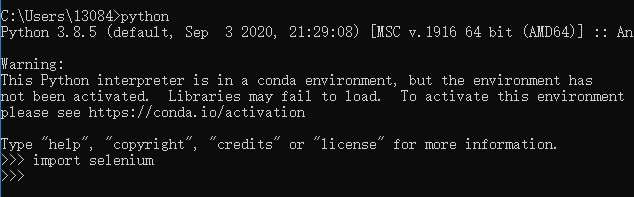

Selenium库的安装比较简单一行代码就行:

pip install selenium也可以到PyPI下载对应的wheel文件,然后进入到wheel文件目录,使用pip安装:

pip install .........whl安装验证,进入Python命令行交互模式,如下图:

这样Selenium就安装完毕了。

04

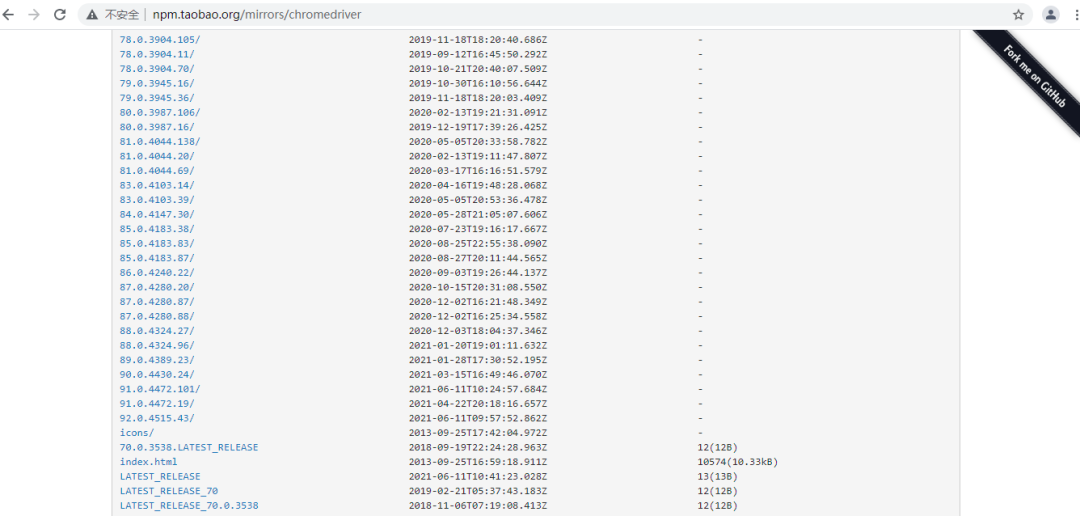

ChromeDriver安装

首先我们先查看Chrome的版本:点击Chrome菜单“帮助”--->“关于Google Chrome”,即可查看Chrome的版本号,如下图:

打开ChromeDriver的官方网站,根据自身Chrome浏览器版本下载ChromeDriver并安装:

注意:ChromeDriver和Chrome浏览器一定要对应,否则可能无法正常工作。

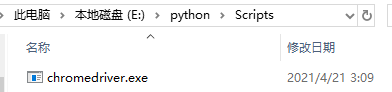

ChromeDriver的环境变量配置,直接将chromedriver.exe文件拖到Python的Scripts目录下。

到这来,准备工作就完成了,下面我们正式开始抓取当当网的畅销图书排行。

05

实战演练

首先,我们进入当当网的畅销图书网页,我们要利用Selenium抓取图书信息并用pyquery解析得到图书的排名、图片、名称、价格、评论等信息。如下图:

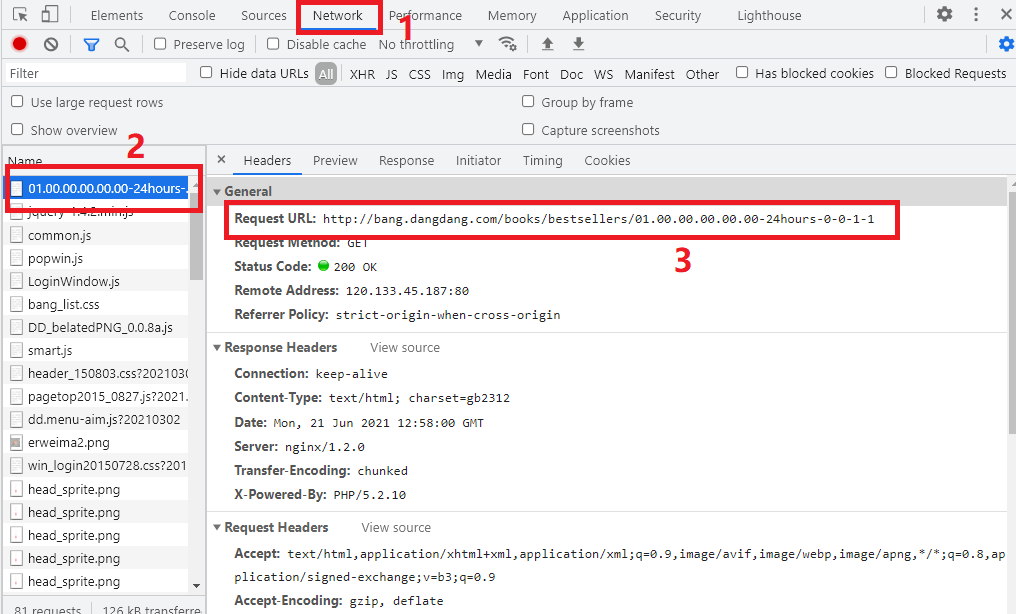

进入开发者工具中的Network,查看Request URL,如下图所示:

在页面下方,有个分页导航,我们点击下一页,观察Request URL的变化:

http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-24hours-0-0-1-1 #第1页

http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-24hours-0-0-1-2 #第2页

http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-24hours-0-0-1-23 #第23页

http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-24hours-0-0-1-page #第n页我们发现该URL只有最后面的那个数字发生变化,所以我们构造的URL就非常简单了,那个page就是翻页的关键字。

06

首页爬取

首先我们先声明chrome浏览器对应,webdriver支持主流的浏览器,比如说:谷歌浏览器、火狐浏览器、IE浏览器等等。通过WebDriverWait()方法,指定最长等待时间,当规定时间内没加载出来就抛出异常。通过page参数来进行翻页。

代码如下:

browser=webdriver.Chrome()

wait=WebDriverWait(browser,10)

def index_page(page):

print('正在爬取第',page,'页')

try:

url='http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-24hours-0-0-1-'+str(page)

browser.get(url)

get_booklist()

except TimeoutException:

index_page(page)07

解析商品列表

接下来,我们就可以实现get_booklist()方法来解析商品列表了,这里我们直接调用page_source获取页面源代码,然后用pyquery进行解析,实现代码如下:

def get_booklist():

html=browser.page_source

doc=pq(html)

items=doc('.bang_list li').items()

for item in items:

book={

'排名':item.find('.list_num').text(),

'书名':item.find('.name').text(),

'图片':item.find('.pic img').attr('src'),

'评论数':item.find('.star a').text(),

'推荐':item.find('.tuijian').text(),

'作者':item.find('.publisher_info a').text(),

'日期':item.find('.publisher_info span').text(),

'原价':item.find('.price_r').text().replace('¥',''),

'折扣':item.find('.price_s',).text(),

'电子书':item.find('.price_e').text().replace('电子书:','').replace('¥','')

}

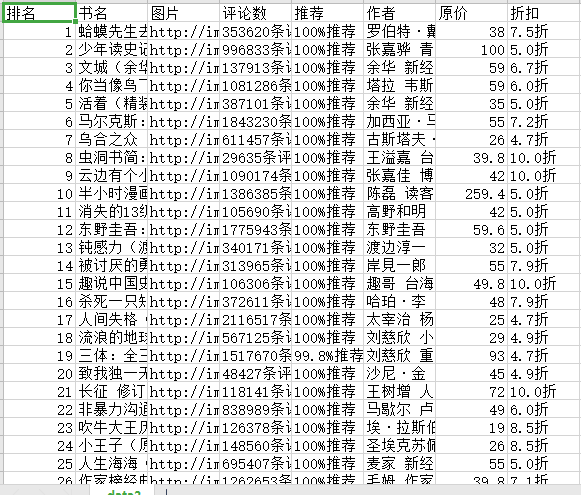

saving_book(book)08

保存数据

接下来,我们将书本信息保存为csv格式,实现代码如下:

with open('data.csv','a',newline='',)as csvfile:

writer=csv.writer(csvfile)

writer.writerow(['排名','书名','图片','评论数','推荐','作者','原价','折扣','电子书'])

def saving_book(book):

with open('data.csv', 'a', newline='')as csfile:

writer = csv.writer(csfile)

writer.writerow([book.get('排名'), book.get('书名'), book.get('图片'), book.get('评论数'), book.get('推荐'), book.get('作者'),book.get('原价'),book.get('折扣'),book.get('电子书')])09

遍历每页

刚才我们所定义的index_page()方法需要接收参数page,page代表页码,这里我们实现页码遍历即可,实现代码如下:

if __name__ == '__main__':

for page in range(1,3):

index_page(page)这里我们只遍历2页,感兴趣的可以遍历多页。

10

结果展示

好了,关于Python爬虫——Selenium爬取当当畅销图书排行讲到这里了,感谢观看!我们下篇文章再见!

---End---

往期精彩文章推荐:

欢迎各位大佬点击链接加入群聊【helloworld开发者社区】:https://jq.qq.com/?_wv=1027&k=mBlk6nzX进群交流IT技术热点。

本文转自 https://mp.weixin.qq.com/s/wU3bo7PH86HnsEnikuU6Wg,如有侵权,请联系删除。