点击上方蓝色字体,选择“设为星标”

回复”资源“获取更多资源

点击右侧关注,大数据开发领域最强公众号!

点击右侧关注,暴走大数据!

HDFS应用场景、原理、基本架构及使用方法

HDFS优点和缺点

HDFS优点

1、高容错性

数据自动保存多个副本

副本丢失后,自动恢复

2、适合批处理

移动计算而非数据

数据位置暴露给计算框架

3、适合大数据处理

GB、TB、甚至PB级数据

百万规模以上的文件数量

10K+节点规模

4、流式文件访问

一次性写入,多次读取

保证数据一致性

5、可构建在廉价机器上

通过多副本提高可靠性

提供了容错和恢复机制

HDFS缺点

1、低延迟数据访问

比如毫秒级-达不到

低延迟与高吞吐率

2、小文件存取

占用NameNode大量内存

寻道时间超过读取时间

3、并发写入、文件随机修改

一个文件只能有一个写者

仅支持append

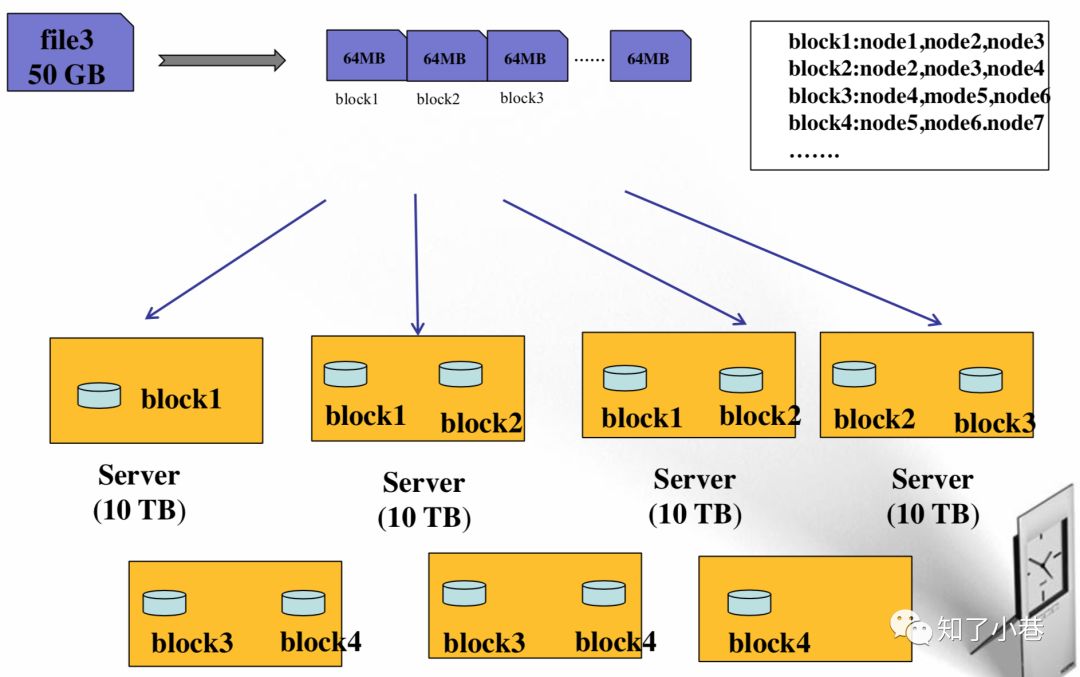

分布式文件系统的一种实现方式:把大文件根据规则切分成小文件存储在不同的机器上

HDFS基本架构和原理

HDFS设计思想

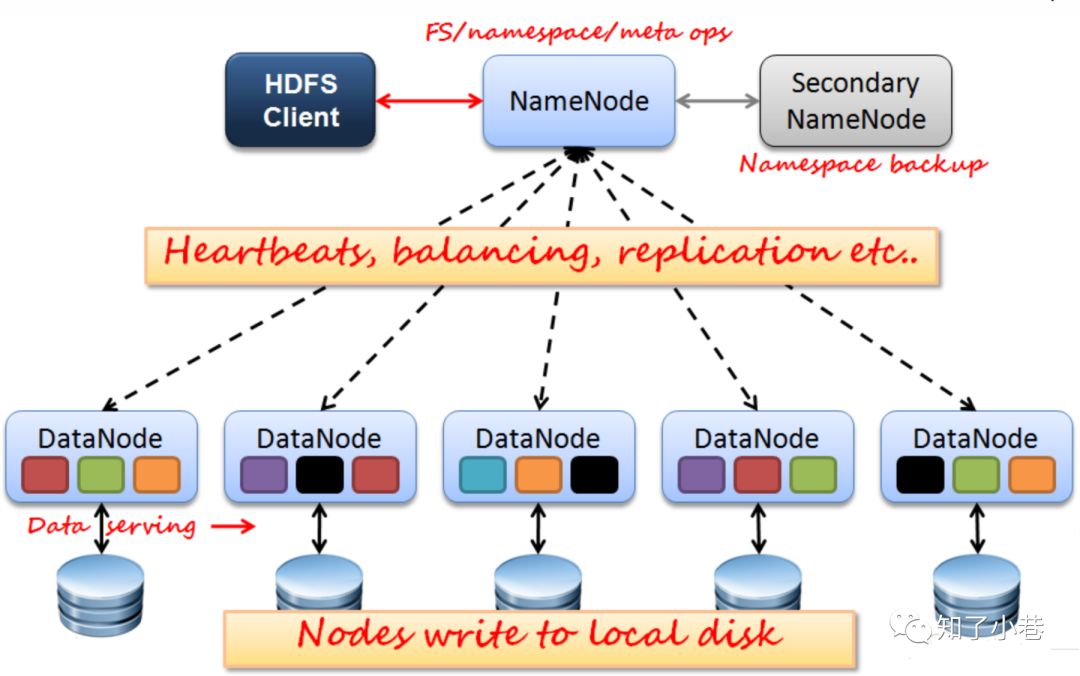

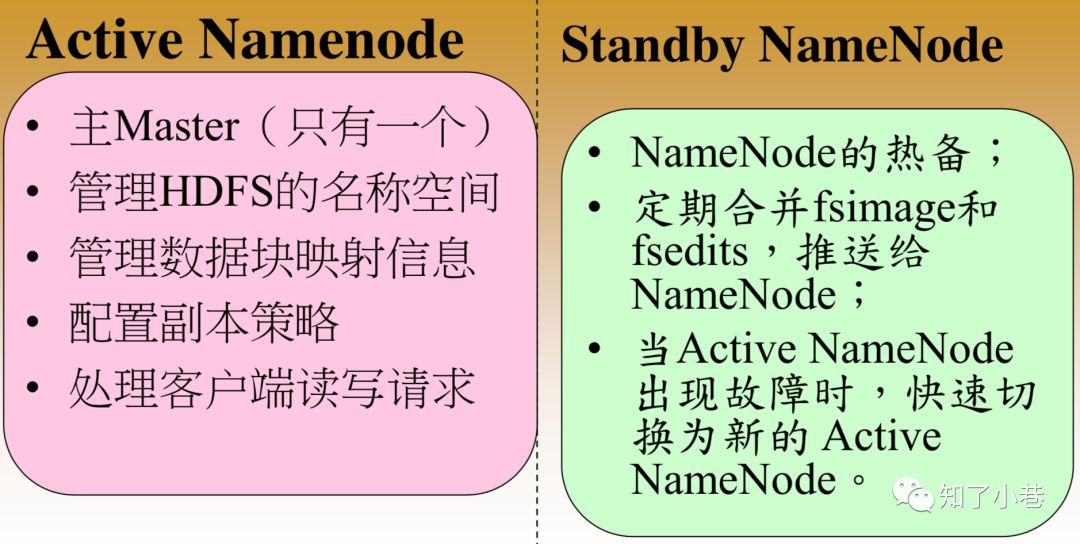

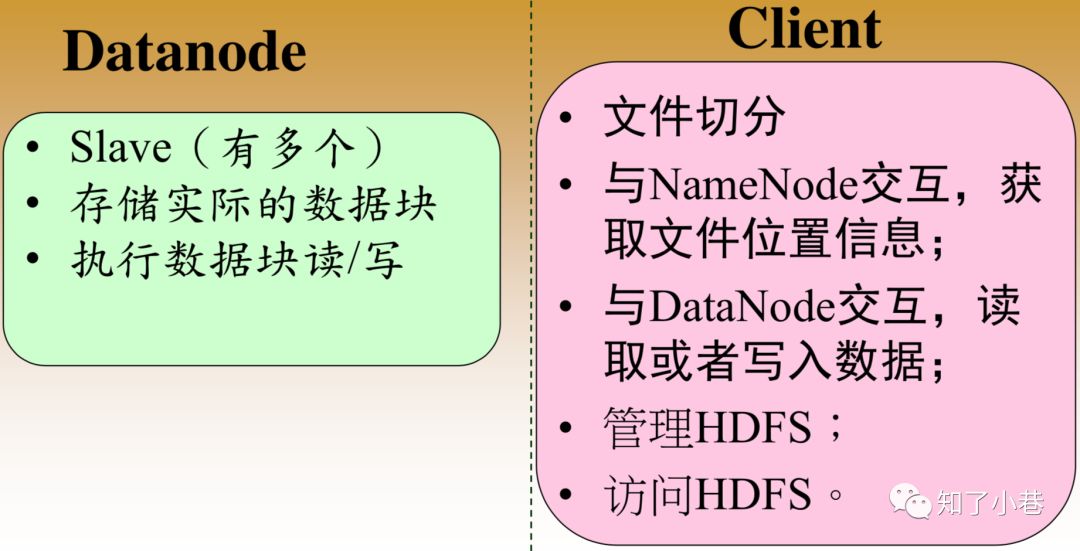

HDFS架构

HDFS数据块

1、文件被切分成固定大小的数据块

默认数据块大小为128MB,可配置

若文件大小不到128MB,则单独存成一个block

2、为何数据块如此之大

数据传输时间超过寻道时间(高吞吐率)

3、一个文件存储方式

按大小被切分成若干个block,存储到不同节点上

默认情况下每个block有三个副本[最小的2N+1>1]

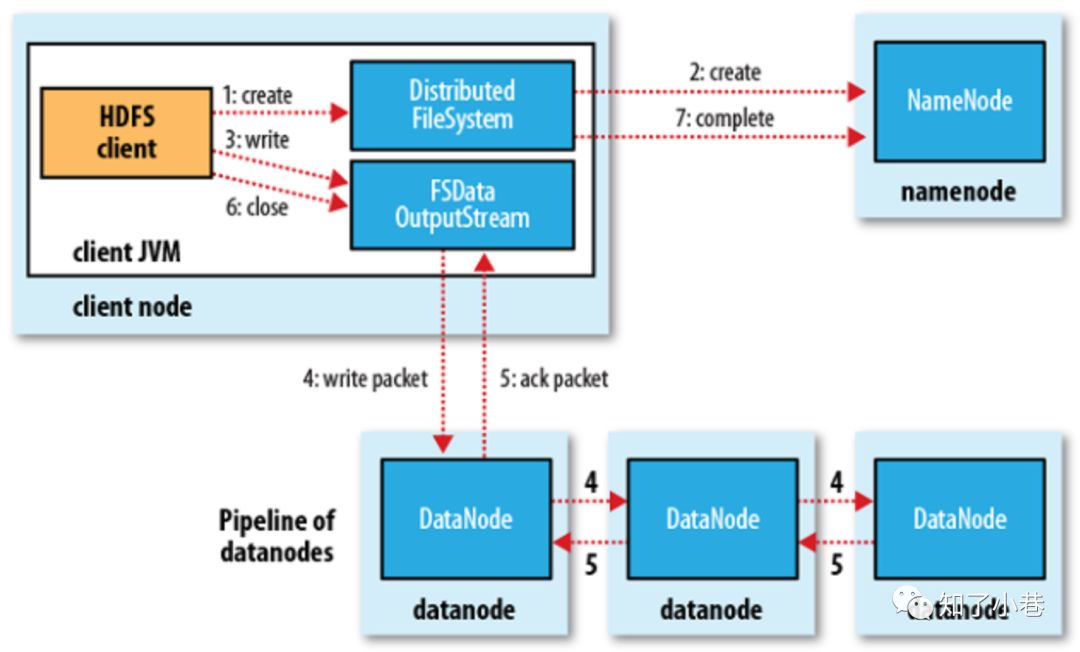

HDFS写流程

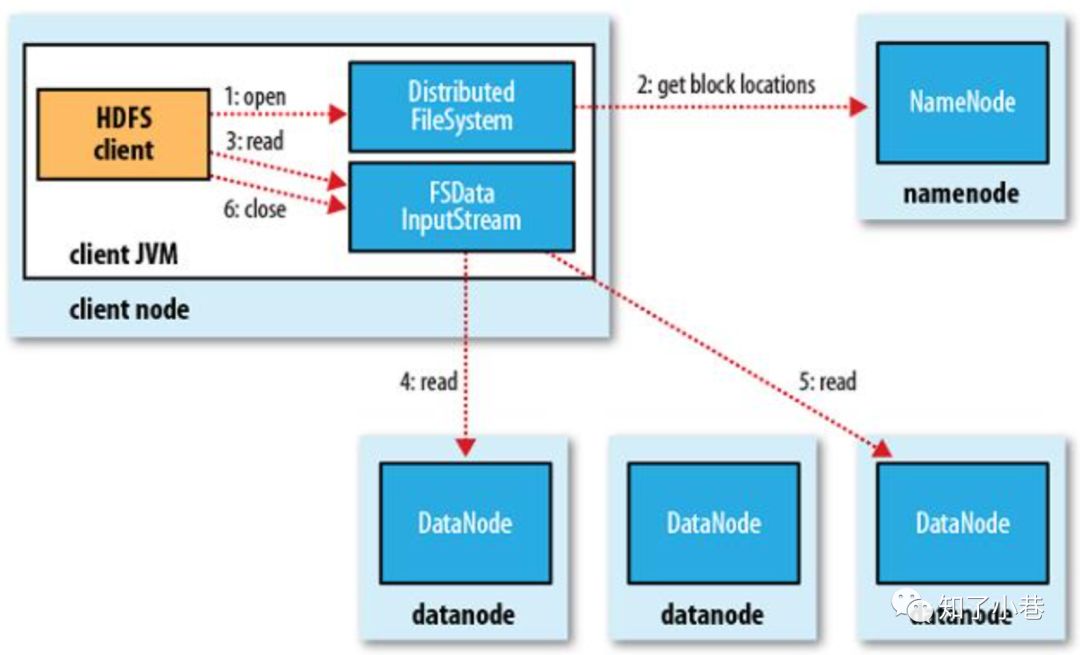

HDFS读流程

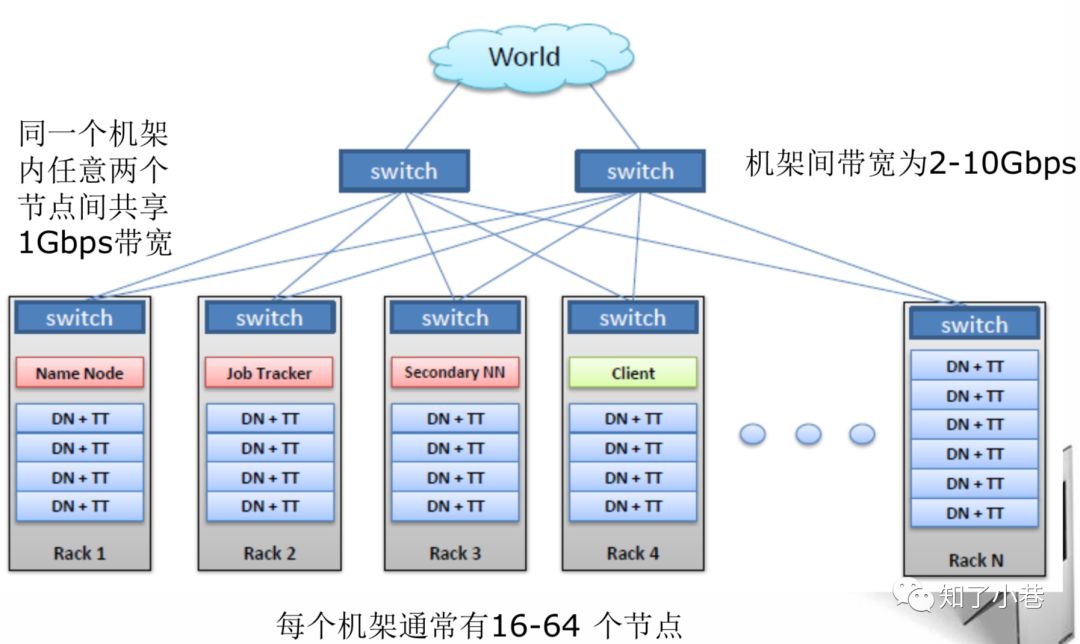

HDFS典型物理拓扑

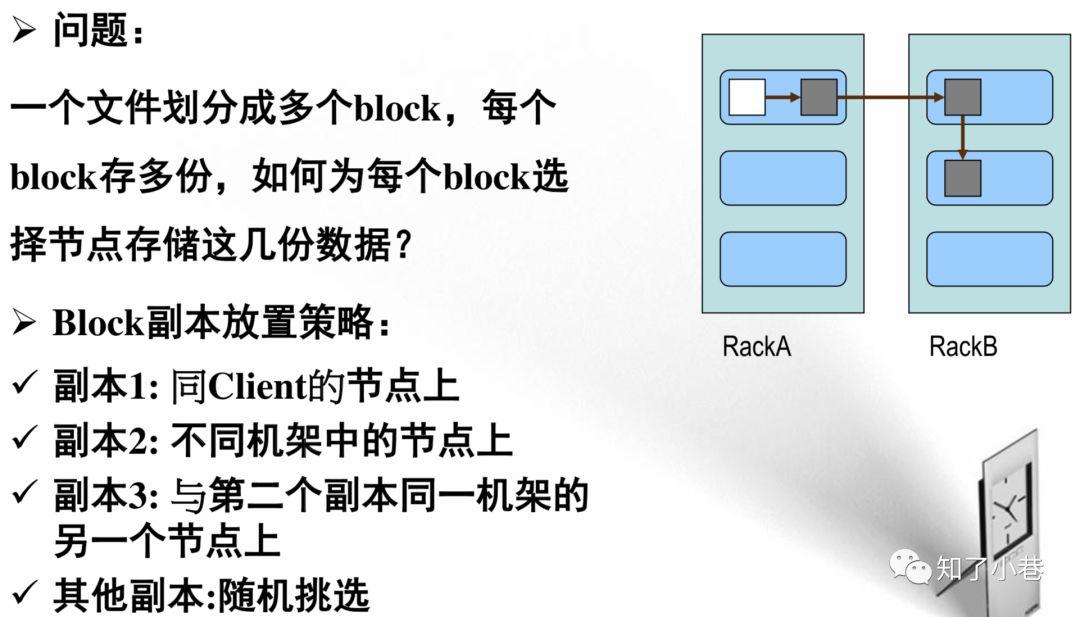

HDFS副本设置策略

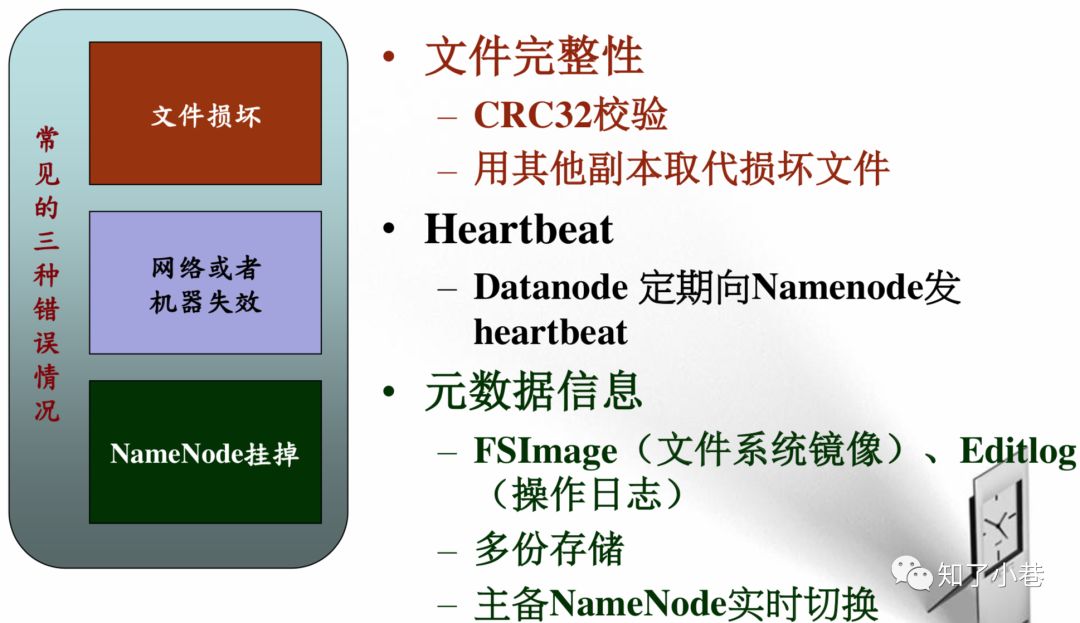

HDFS可靠性策略

HDFS不适合存储小文件

1、元信息存储在NameNode内存中

一个节点的内存是有限的

2、存取大量小文件消耗大量的寻道时间

类比拷贝大量小文件与拷贝同等大小的一个大文件

3、NameNode存储block数目是有限的

一个block元信息消耗大约150 byte内存

存储1亿个block,大约需要20GB内存

如果一个文件大小为10K,则1亿个文件大小仅为1TB(但要消耗掉NameNode 20GB内存)

HDFS程序设计

HDFS访问方式

HDFS Shell命令

HDFS Java API

HDFS REST API

HDFS Fuse:实现了fuse协议

HDFS lib hdfs:C/C++访问接口

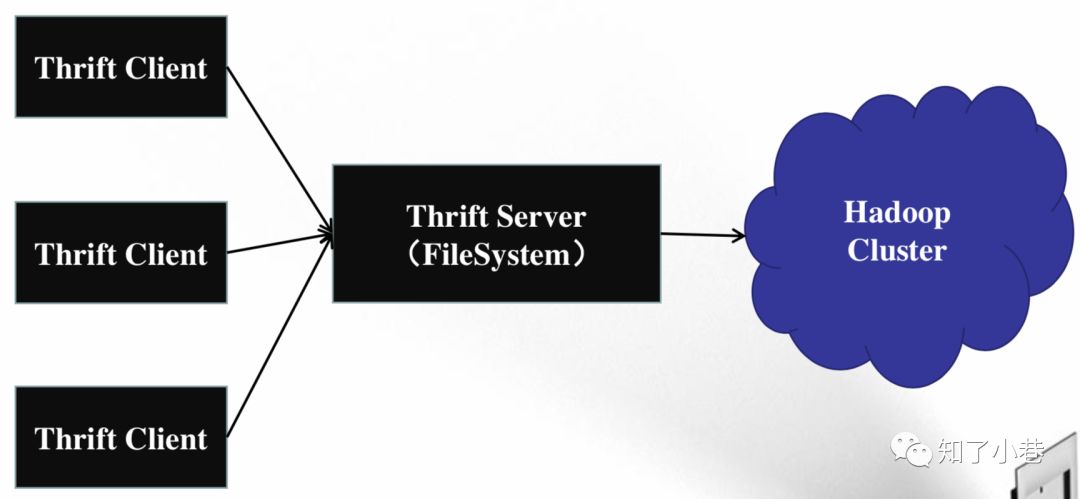

HDFS 其他语言编程API

使用thrift实现

支持C++、Python、php、C#等语言

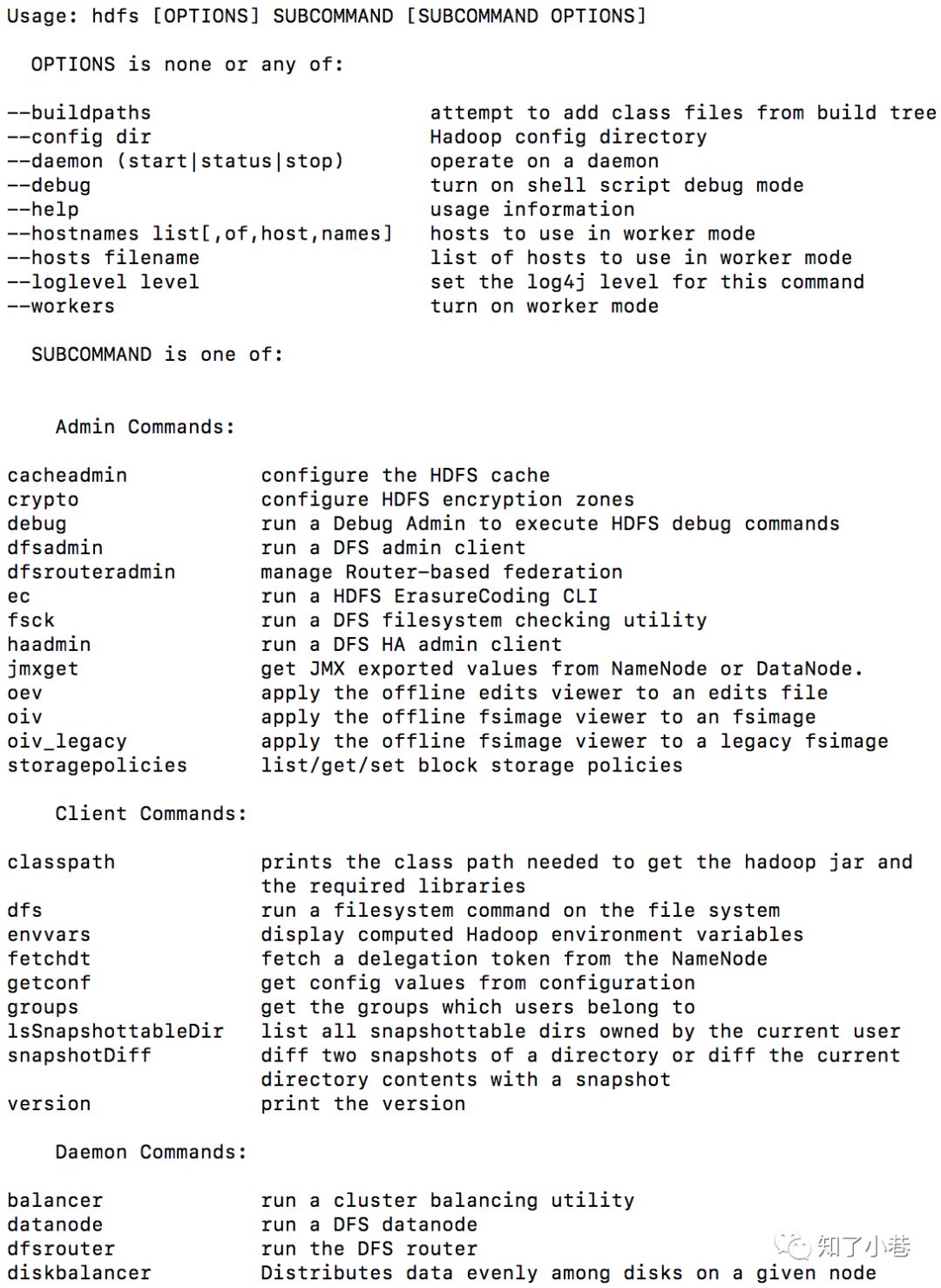

HDFS Shell命令

$ hdfs version

Hadoop 3.1.1

Usage: hdfs [OPTIONS] SUBCOMMAND [SUBCOMMAND OPTIONS]

SUBCOMMAND:

Admin Commands

Client Commands

Daemon Commands

不同版本的Hadoop命令还是有差异的,具体会在后面新的文章中总结。

$ hadoop dfsadmin

WARNING: Use of this script to execute dfsadmin is deprecated.

WARNING: Attempting to execute replacement "hdfs dfsadmin" instead.

$ hadoop fsck

WARNING: Use of this script to execute fsck is deprecated.

WARNING: Attempting to execute replacement "hdfs fsck" instead.

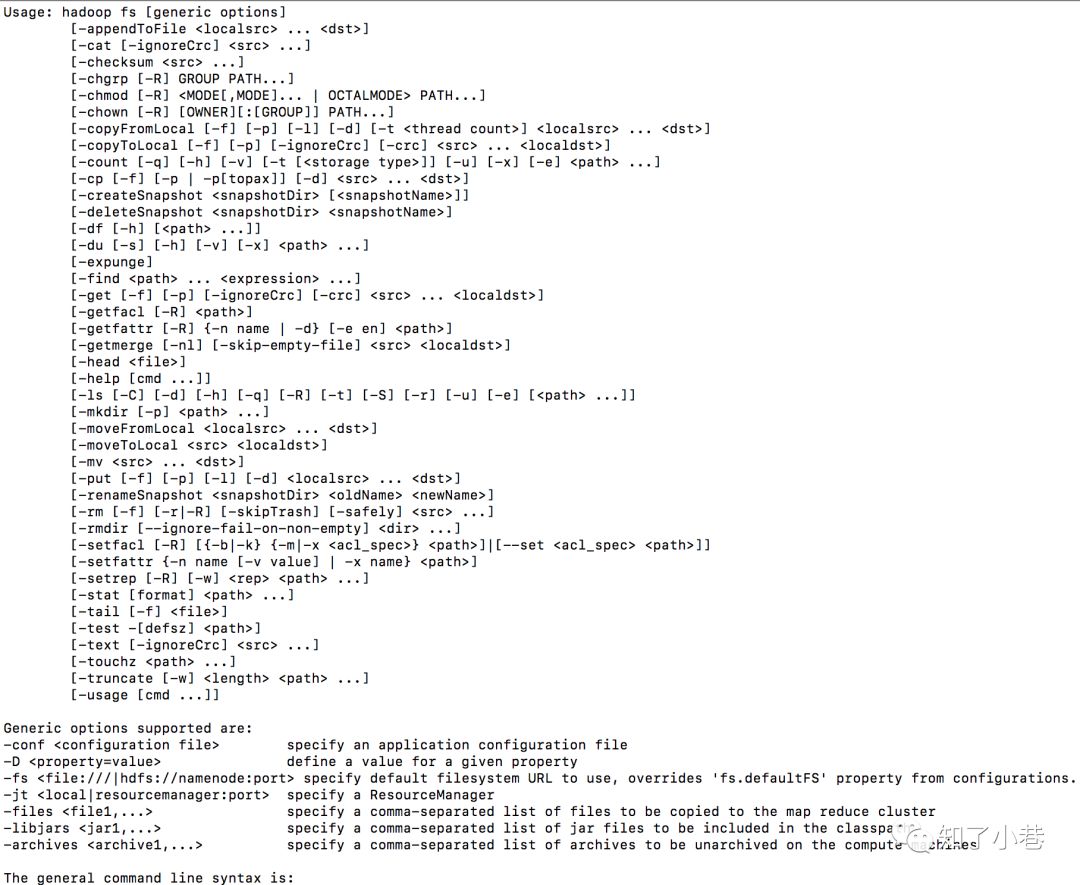

HDFS Shell文件操作命令

Usage: hadoop fs [generic options]

1、将本地文件上传到HDFS上

bin/hadoop fs -copyFromLocal /local/data /hdfs/data

2、删除文件/目录

bin/hadoop fs -rmr /hdfs/data

3、创建目录

bin/hadoop fs -mkdir /hdfs/data

HDFS管理脚本

在sbin目录下

start-all.sh

start-dfs.sh

start-yarn.sh

hadoop-deamon(s).sh

单独启动某个服务

hadoop-deamon.sh start namenode

hadoop-deamons.sh start namenode(通过SSH登录到各个节点)

数据均衡器balancer

1、数据块重分布

bin/start-balancer.sh -threshold

2、percentage of disk capacity

HDFS达到平衡状态的磁盘使用率偏差值

值越低各节点越平衡,但消耗时间也更长

HDFS设置目录份额

1、限制一个目录最多使用磁盘空间

$ hdfs dfsadmin -setSpaceQuota 128M /test

2、限制一个目录包含的最多子目录和文件数目

$ hdfs dfsadmin -setQuota 100 /test

增加和移除DataNode节点

1、加入新的datanode

步骤1:将已存在datanode上的安装包(包括配置文件等)拷贝到新datanode上

步骤2:启动新datanode

sbin/hadoop-deamon.sh start datanode

2、移除旧datanode

步骤1:将datanode加入黑名单,并更新黑名单,在NameNode上,将datanode的host或者ip加入配置选项dfs.hosts.exclude指定的文件中

步骤2:移除datanode

bin/hdfs dfsadmin -refreshNodes

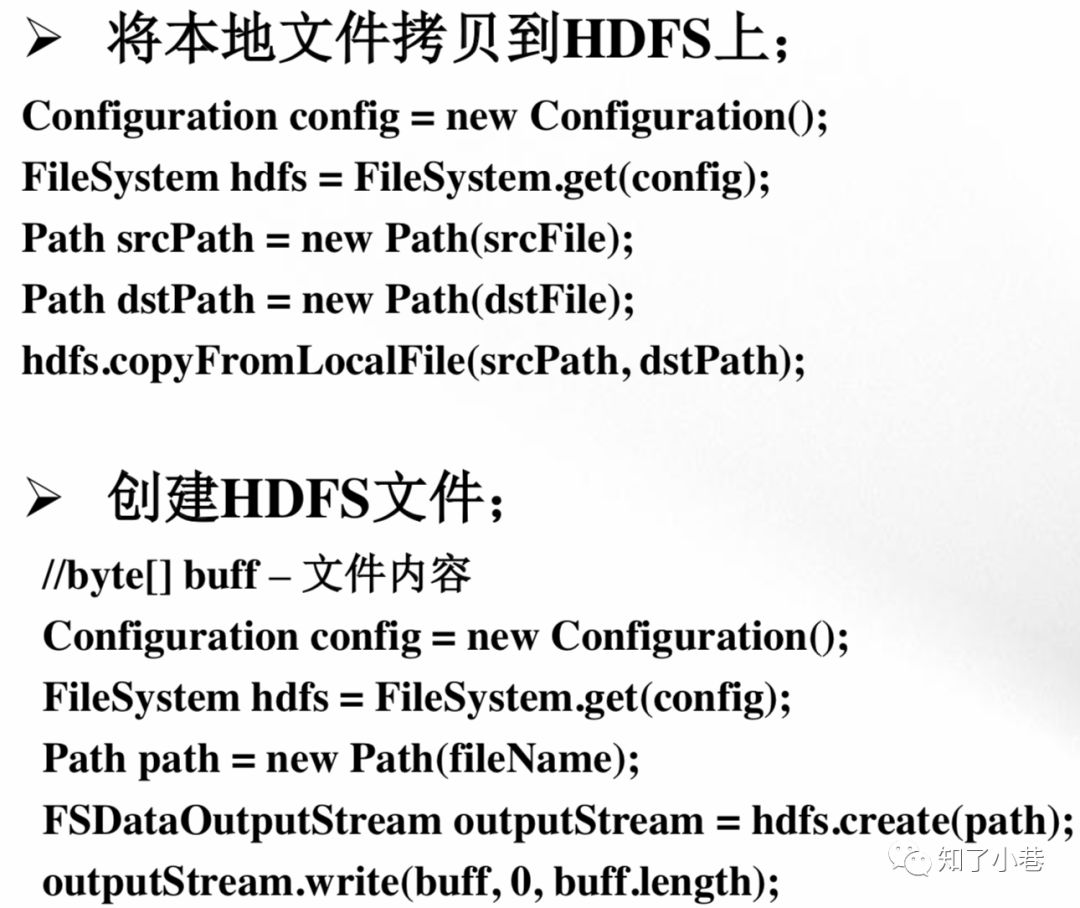

HDFS JavaAPI

1、Configuration类

该类的对象封装了配置信息,这些配置信息来自core-*.xml

2、FileSystem类

文件系统类,可使用该类的方法对文件根目录进行操作。一般通过FileSystem的静态方法get获得一个文件系统对象

3、FSDataInputStream和FSDataOutputStream类

HDFS中的输入输出流。分别通过FileSystem的open 方法和create方法获得。

以上类均来自java包:org.apache.hadoop.fs

HDFS Thrift API

通过Thrift实现多语言Client访问HDFS

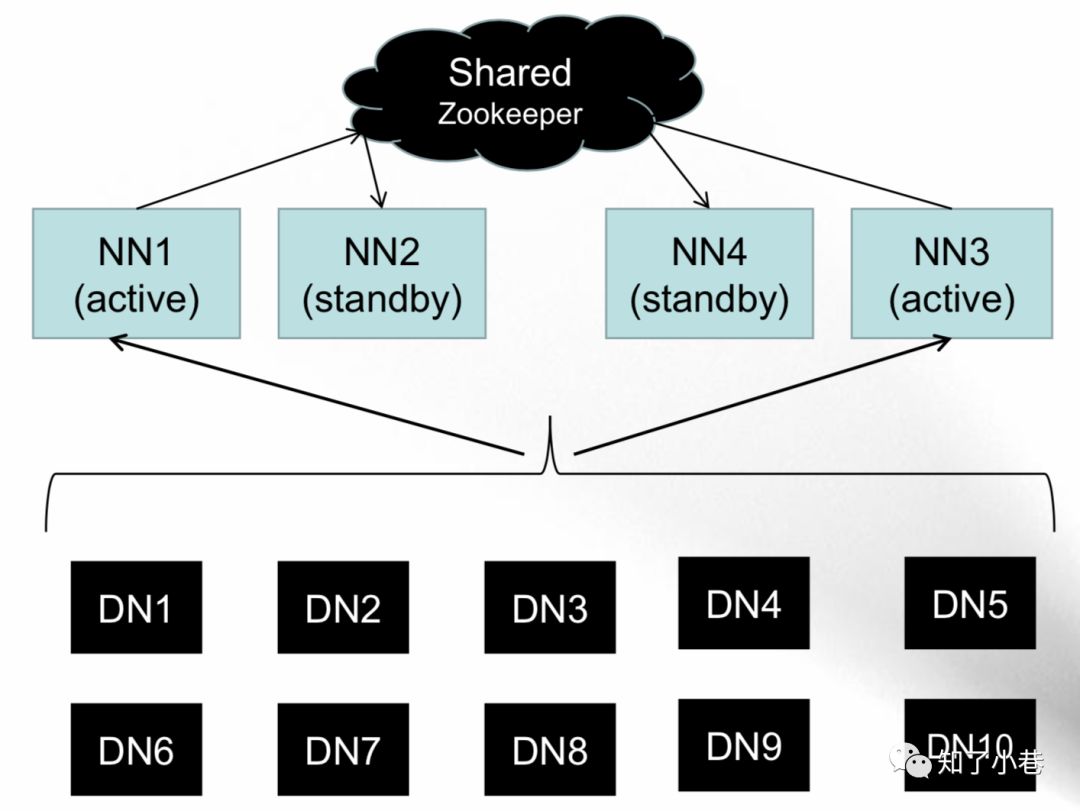

Hadoop2.0新特性

NameNode HA

NameNode Federation

HDFS 快照(snapshot)

HDFS 缓存(in-memory cache)

HDFS ACL

异构层级存储结构(Heterogeneous Storage hierarchy)

HA与Federation

异构层级存储结构

1、HDFS将所有存储介质抽象成性能相同的Disk

dfs.datanode.data.dir

/dir0,/dir1,/dir2,/dir3

2、存储介质种类繁多,一个集群中存在多种异构介质

磁盘、SSD、RAM等

3、多种类型的任务企图同时运行在同一个Hadoop集群中

批处理,交互式处理,实时处理

4、不同性能要求的数据,最好存储在不同类别的存储介质上

5、每个节点是由多种异构存储介质构成的

dfs.datanode.data.dir

[disk]/dir0,[disk]/dir1,[ssd]/dir2,[ssd]/dir3

6、HDFS仅提供了一种异构存储结构,并不知道存储介质的性能

HDFS为用户提供了API,以控制目录/文件写到什么介质上

HDFS为管理员提供了管理工具,可限制每个用户对 每种介质的可使用份额

完成度-待研究[毕竟3.x版本了]

HDFS ACL权限控制

1、对当前基于POSIX文件权限管理的补充(HDFS-4685)

2、启动该功能;

将dfs.namenode.acls.enabled置为true

3、使用方法

hdfs dfs -setfacl -m user:tom:rw- /bank/exchange

hdfs dfs -setfacl -m user:lucy:rw- /bank/exchange

hdfs dfs -setfacl -m group:team2:r-- /bank/exchange

hdfs dfs -setfacl -m group:team3:r-- /bank/exchange

HDFS快照

1、HDFS上文件和目录是不断变化的,快照可以帮助用户保存某个时刻的数据

2、HDFS快照的作用

防止用户误操作删除数据

数据备份

3、一个目录可以产生快照,当且仅当它是Snapshottable

bin/hdfs dfsadmin allowSnapshot

4、创建/删除快照

bin/hdfs dfs -createSnapshot [ ]

bin/hdfs dfs -deleteSnapshot [ ]

5、快照存放位置和特点

快照是只读的,不可修改

快照位置:

/.snapshot

/.snapshot/snap_name

HDFS缓存

1、HDFS自身不提供数据缓存功能,而是使用OS缓存

容易内存浪费,eg.一个block三个副本同时被缓存

多种计算框架共存,均将HDFS作为共享存储系统

MapReduce:离线计算,充分利用磁盘

Impala:低延迟计算,充分利用内存

Spark:内存计算框架

2、HDFS应让多种混合计算类型共存一个集群中

合理的使用内存、磁盘等资源

比如,高频访问的特点文件应被尽可能长期缓存,防止置换到磁盘上

3、用户需通过命令显式的将一个目录或文件加入/移除缓存

不支持块级别的缓存

不支持自动化缓存

可设置缓存失效时间

4、缓存目录:仅对一级文件进行缓存

不会递归缓存所有文件与目录

5、以pool的形式组织缓存资源

借助YARN的资源管理方式,将缓存划分到不同pool中

每个pool有类linux权限管理机制、缓存上限、失效时间等

6、独立管理内存,未与资源管理系统YARN集成

用户可为每个DN设置缓存大小,该值独立于YARN

本文分享自微信公众号 - 大数据技术与架构(import_bigdata)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。