在Python爬虫开发中,经常会遇到DNS解析错误,这是一个常见且也令人头疼的问题。DNS解析错误可能会导致爬虫失败,但幸运的是,我们可以采取一些策略来处理这些错误,确保爬虫能够正常运行。本文将介绍什么是DNS解析错误,可能的原因,以及在爬取过程中遇到DNS解析错误时应该如何解决。

什么是DNS解析错误

DNS(Domain Name System)解析错误是指在进行网络请求时,系统无法将域名解析为对应的IP地址。这个错误可能会导致爬虫无法连接到目标网站,从而中断爬取过程。DNS解析错误通常以各种形式的异常信息或错误代码的形式出现,例如cURL库中的错误码。

常见报错的信息

在爬虫过程中,如果发生DNS解析错误,通常会看到一些常见的报错信息,这些信息有助于识别问题的根本原因。以下是一些常见的DNS解析错误信息:

Name or service not known:这是一个常见的DNS解析错误信息,表示系统无法解析给定的域名。

DNS resolution failed:这个错误信息表明DNS解析失败,可能是因为网络连接问题或无法找到域名的IP地址。

Could not resolve host:这个信息表示无法解析指定的主机名,通常是因为域名不存在或网络不可达。

Temporary failure in name resolution:这个错误表明DNS解析过程中发生了临时错误,可能是DNS服务器问题或网络问题。

了解这些错误信息有助于定位和解决DNS解析错误

爬取过程中遇到DNS解析错误怎么解决

在爬取过程中遇到DNS解析错误时,有一些策略可以帮助您解决问题并继续爬取。

在Python爬虫开发中,经常会遇到DNS解析错误,这是一个常见且也令人头疼的问题。DNS解析错误可能会导致爬虫失败,但幸运的是,我们可以采取一些策略来处理这些错误,确保爬虫能够正常运行。本文将介绍什么是DNS解析错误,可能的原因,以及在爬取过程中遇到DNS解析错误时应该如何解决。

什么是DNS解析错误

DNS(Domain Name System)解析错误是指在进行网络请求时,系统无法将域名解析为对应的IP地址。这个错误可能会导致爬虫无法连接到目标网站,从而中断爬取过程。DNS解析错误通常以各种形式的异常信息或错误代码的形式出现,例如cURL库中的错误码。

常见报错的信息

在爬虫过程中,如果发生DNS解析错误,通常会看到一些常见的报错信息,这些信息有助于识别问题的根本原因。以下是一些常见的DNS解析错误信息:

Name or service not known:这是一个常见的DNS解析错误信息,表示系统无法解析给定的域名。

DNS resolution failed:这个错误信息表明DNS解析失败,可能是因为网络连接问题或无法找到域名的IP地址。

Could not resolve host:这个信息表示无法解析指定的主机名,通常是因为域名不存在或网络不可达。

Temporary failure in name resolution:这个错误表明DNS解析过程中发生了临时错误,可能是DNS服务器问题或网络问题。

了解这些错误信息有助于定位和解决DNS解析错误

爬取过程中遇到DNS解析错误怎么解决

在爬取过程中遇到DNS解析错误时,有一些策略可以帮助您解决问题并继续爬取。

- 检查网络连接 首先,请确保您的网络连接正常。尝试访问其他网站,确保您可以正常访问互联网。如果您的网络连接存在问题,解决这些问题可能会解决DNS解析错误。

- 检查域名存在性 确保您要访问的域名存在并且可用。您可以尝试在浏览器中手动访问该域名,以验证它是否可以正常加载。如果域名不存在或不可用,您需要考虑更改目标或等待域名恢复可用。

- 检查DNS服务器 有时DNS服务器可能出现问题。您可以尝试更改您的DNS设置为其他可靠的DNS服务器,如Google DNS(8.8.8.8和8.8.4.4),以查看是否解决了问题。

- 检查代理设置 如果您使用代理服务器来进行爬取,确保代理服务器的配置是正确的。代理服务器可能会影响DNS解析,因此请仔细检查代理设置。

- 超时和重试 在进行HTTP请求时,设置适当的超时时间,并实施重试策略。这样,当DNS解析失败时,您的爬虫可以等待一段时间然后重试,而不是立即放弃。

- 使用备用DNS解析库

Python中有多个DNS解析库可供选择。尝试使用不同的库,看看是否可以解决DNS解析问题。常见的DNS解析库包括dnspython和socket库。

解决过程

下面,我们将提供一个完整的示例,演示如何在Python爬虫中处理cURL中的DNS解析错误。我们将使用Python的requests库来进行HTTP请求,并设置代理服务器来模拟实际情况。首先,让我们导入所需的库和设置代理信息:

from requests.exceptions import RequestException from urllib3.util.retry import Retry from urllib3.exceptions import MaxRetryError

设置代理信息

proxyHost = "www.16yun.cn" proxyPort = "5445" proxyUser = "16QMSOML" proxyPass = "280651"

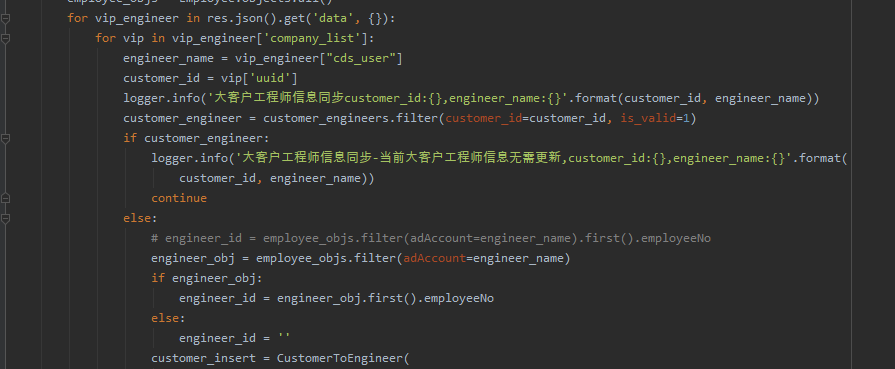

接下来,我们定义一个函数来进行HTTP请求:

``` def make_request(url):

# 创建HTTP请求会话

session = requests.Session()

retries = Retry(total=5, backoff_factor=0.1, status_forcelist=[500, 502, 503, 504])

session.mount("http://", requests.adapters.HTTPAdapter(max_retries=retries))

session.mount("https://", requests.adapters.HTTPAdapter(max_retries=retries))

# 设置代理

proxy_url = f"http://{proxyUser}:{proxyPass}@{proxyHost}:{proxyPort}"

session.proxies = {"http": proxy_url, "https": proxy_url}

try:

response = session.get(url)

response.raise_for_status() # 检查是否有HTTP错误

return response.text

except RequestException as e:

print(f"Request error: {e}")

return None

except MaxRetryError as e:

print(f"Max retries exceeded: {e}")

return None

现在,我们可以使用这个函数来进行HTTP请求,并处理可能的DNS解析错误:

html = make_request(url)

if html is not None:

# 处理HTML页面

# ...

else:

print("Failed to fetch data due to DNS resolution error.")