Apache Hive TM

(文件存储格式)

Hive 文件存储格式主要包括以下几类:

1、TEXTFILE

2、SEQUENCEFILE

3、RCFILE

4、ORCFILE(0.11以后出现)

其中TEXTFILE为默认格式,建表时不指定_默认_为这个格式,导入数据时会直接把数据文件拷贝到hdfs上不进行处理;

SEQUENCEFILE,RCFILE,ORCFILE格式的表不能直接从本地文件导入数据,数据要先导入到textfile格式的表中, 然后再从表中用insert导入SequenceFile,RCFile,ORCFile表中。

Apache Hive

Hive环境

⊙前提创建环境:

(本系列教程使用,CDH 官方快速入门)

hive-common-1.1.0-cdh5.13.0

数据结构

Data Structure

数据源(来源网络)

◆ ◆ ◆ ◆ ◆

一、TEXTFILE

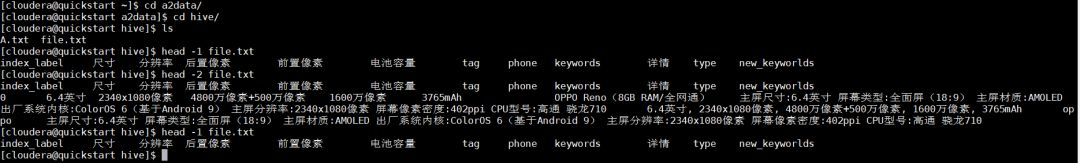

创建一张格式为:TEXTFILE, 表名为: nsf_textfile

并且导入服务器本地数据!

create table if not exists a2data.nsf_testfile(id string,chicun string,fbl string,qz string,hz string ,dc string,tag string ,phone string ,keywords string,xq string,type string, new_keyworlds string) row format delimited fields terminated by '\t' stored as textfile;

load data local inpath '/home/cloudera/a2data/hive/file.txt' overwrite into table a2data.nsf_testfile;

TEXTFILE:默认格式,数据不做压缩,这样就会导致磁盘开销大,数据解析开销大。

可结合Gzip、Bzip2 使用(系统自动检查,执行查询时自动解压),但使用这种方式,hive不会对数据进行切分,从而无法对数据进行并行操作。

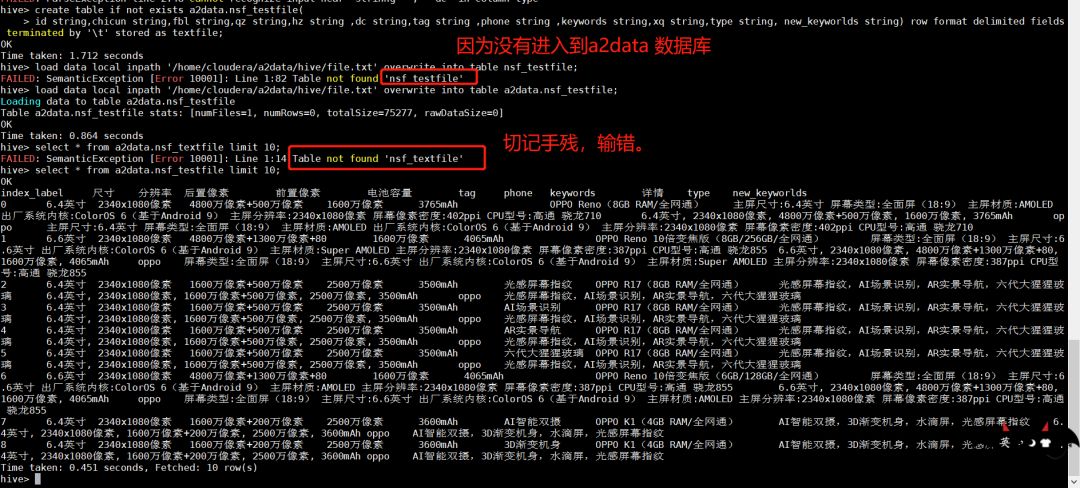

示例:create table if not exists a2data.textfile_table(id string,chicun string,fbl string,qz string,hz string ,dc string,tag string ,phone string ,keywords string,xq string,type string, new_keyworlds string)row format delimitedfields terminated by '\t'stored as textfile;插入数据操作:set hive.exec.compress.output=true; set mapred.output.compress=true; set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec; set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec; insert overwrite table a2data.textfile_table select * from a2data.nsf_testfile;

二、SEQUENCEFILE

SequenceFile是Hadoop API提供的一种二进制文件支持,其具有使用方便、可分割、可压缩的特点。

SequenceFile支持三种压缩选择:NONE,RECORD,BLOCK。Record压缩率低,一般建议使用BLOCK压缩。

示例:create table if not exists a2data.seqfile_table(id string,chicun string,fbl string,qz string,hz string ,dc string,tag string ,phone string ,keywords string,xq string,type string, new_keyworlds string)row format delimitedfields terminated by '\t'stored as sequencefile;插入数据操作:set hive.exec.compress.output=true; set mapred.output.compress=true; set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec; set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec; SET mapred.output.compression.type=BLOCK;insert overwrite table a2data.seqfile_table select * from a2data.textfile_table;

三、RCFILE

⊙RCFILE是一种行列存储相结合的存储方式。首先,其将数据按行分块,保证同一个record在一个块上,避免读一个记录需要读取多个block。其次,块数据列式存储,有利于数据压缩和快速的列存取。

示例:create table if not exists a2data.rcfile_table(id string,chicun string,fbl string,qz string,hz string ,dc string,tag string ,phone string ,keywords string,xq string,type string, new_keyworlds string)row format delimitedfields terminated by '\t'stored as rcfile;插入数据操作:set hive.exec.compress.output=true; set mapred.output.compress=true; set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec; set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec; insert overwrite table a2data.rcfile_table select * from a2data.textfile_table;

四、ORCFILE(简写ORC)

ORC File,它的全名是Optimized Row Columnar (ORC) file,其实就是对RCFile做了一些优化。这种文件格式可以提供一种高效的方法来存储Hive数据。它的设计目标是来克服Hive其他格式的缺陷。

运用ORC File可以提高Hive的读、写以及处理数据的性能。

和RCFile格式相比,ORC File格式有以下优点:

(1)、每个task只输出单个文件,这样可以减少NameNode的负载;

(2)、支持各种复杂的数据类型,比如: datetime, decimal, 以及一些复杂类型(struct, list, map, and union);

(3)、在文件中存储了一些轻量级的索引数据;

(4)、基于数据类型的块模式压缩:a、integer类型的列用行程长度编码(run-length encoding);b、String类型的列用字典编码(dictionary encoding);

(5)、用多个互相独立的RecordReaders并行读相同的文件;

(6)、无需扫描markers就可以分割文件;

(7)、绑定读写所需要的内存;

(8)、metadata的存储是用 Protocol Buffers的,所以它支持添加和删除一些列。

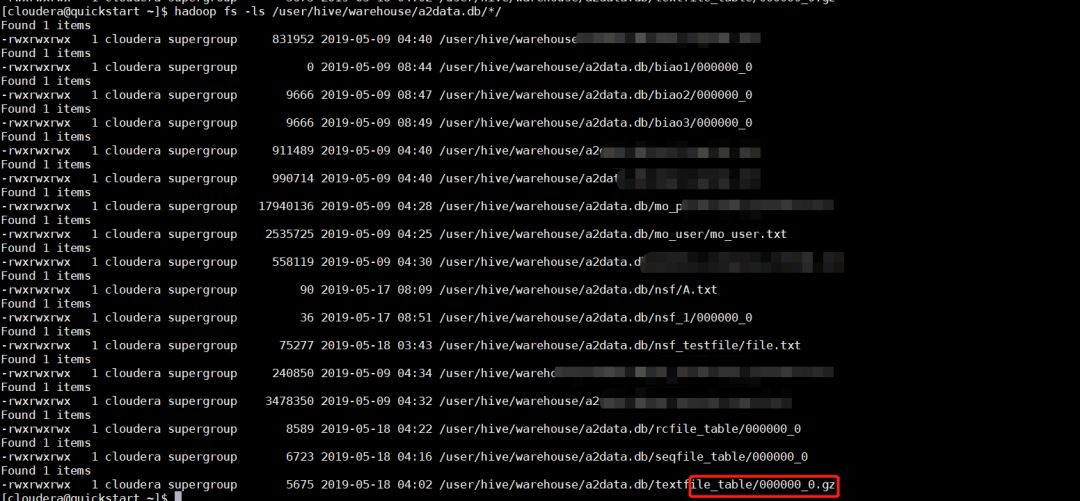

五、再看TEXTFILE、SEQUENCEFILE、RCFILE三种文件的存储情况:

结论

相比**TEXTFILE和_SEQUENCEFILE,RCFILE_由于列式存储方式,数据加载时性能消耗较大,但是具有较好的压缩比和查询响应。数据仓库的特点是一次写入、多次读取,因此,整体来看,RCFILE**相比其余两种格式具有较明显的优势。

扫码

长按关注

关注

惊喜不断

●**__Apache Hive Load Data__**(数据导入方式)

觉得有价值,请点个 在看 !

本文分享自微信公众号 - DataScience(DataScienceTeam)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。