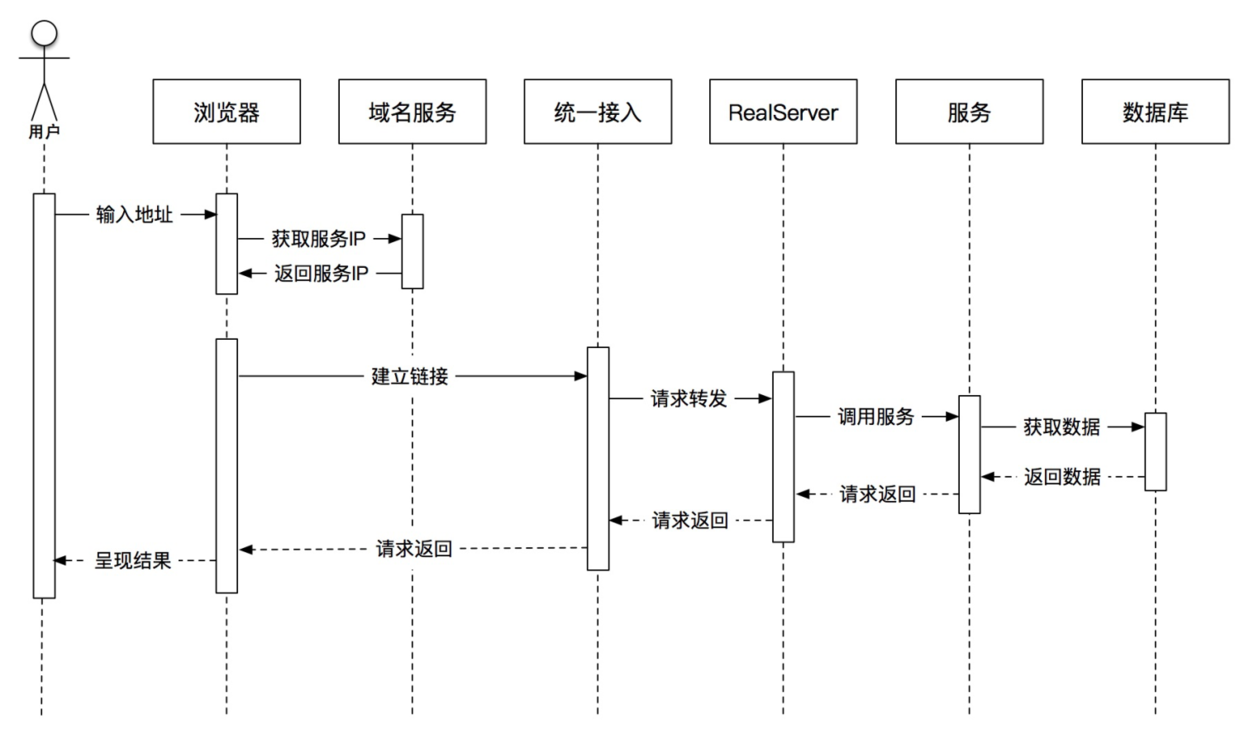

我们日常使用浏览器的步骤为:启动浏览器、打开一个网页、进行交互。而无头浏览器指的是我们使用脚本来执行以上过程的浏览器,能模拟真实的浏览器使用场景。主要是用作爬虫,用以捕捉Web上的各类数据;这里的无头主要是指没有界面,完全是后台操作。它就是一个真实的浏览器。只是这个浏览器是无界面的。 在爬虫中使用无头浏览器有很多的注意事项,比如我们的业务场景是否适合使用无头浏览器、我们可以通过这些方面进行判别,如果目标网站反爬不是很难,可以直接通过简单的http请求进行采集,不适合使用无头浏览器方案。反之如果网站有多种验证机制,例如需要验证登录、js反爬策略,如果研发不能进行网站行为分析的情况下,建议使用无头浏览器伪装正常用户,并且需要搭配代理一起使用,代理建议使用像亿牛云提供的爬虫代理去访问网站效果会更好,这里简单的示例下使用代理的方式:

``` from selenium import webdriver import string import zipfile

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = "t.16yun.cn"

proxyPort = "3111"

# 代理验证信息

proxyUser = "username"

proxyPass = "password"

def create_proxy_auth_extension(proxy_host, proxy_port,

proxy_username, proxy_password,

scheme='http', plugin_path=None):

if plugin_path is None:

plugin_path = r'/tmp/{}_{}@t.16yun.zip'.format(proxy_username, proxy_password)

manifest_json = """

{

"version": "1.0.0",

"manifest_version": 2,

"name": "16YUN Proxy",

"permissions": [

"proxy",

"tabs",

"unlimitedStorage",

"storage",

"<all_urls>",

"webRequest",

"webRequestBlocking"

],

"background": {

"scripts": ["background.js"]

},

"minimum_chrome_version":"22.0.0"

}

"""

background_js = string.Template(

"""

var config = {

mode: "fixed_servers",

rules: {

singleProxy: {

scheme: "${scheme}",

host: "${host}",

port: parseInt(${port})

},

bypassList: ["localhost"]

}

};

chrome.proxy.settings.set({value: config, scope: "regular"}, function() {});

function callbackFn(details) {

return {

authCredentials: {

username: "${username}",

password: "${password}"

}

};

}

chrome.webRequest.onAuthRequired.addListener(

callbackFn,

{urls: ["<all_urls>"]},

['blocking']

);

"""

).substitute(

host=proxy_host,

port=proxy_port,

username=proxy_username,

password=proxy_password,

scheme=scheme,

)

print(background_js)

with zipfile.ZipFile(plugin_path, 'w') as zp:

zp.writestr("manifest.json", manifest_json)

zp.writestr("background.js", background_js)

return plugin_path

proxy_auth_plugin_path = create_proxy_auth_extension(

proxy_host=proxyHost,

proxy_port=proxyPort,

proxy_username=proxyUser,

proxy_password=proxyPass)

option = webdriver.ChromeOptions()

option.add_argument("--start-maximized")

# 如报错 chrome-extensions

# option.add_argument("--disable-extensions")

option.add_extension(proxy_auth_plugin_path)

# 关闭webdriver的一些标志

# option.add_experimental_option('excludeSwitches', ['enable-automation'])

driver = webdriver.Chrome(

chrome_options=option,

executable_path="./chromdriver"

)

# 修改webdriver get属性

# script = '''

# Object.defineProperty(navigator, 'webdriver', {

# get: () => undefined

# })

# '''

# driver.execute_cdp_cmd("Page.addScriptToEvaluateOnNewDocument", {"source": script})

driver.get("https://httpbin.org/ip")这里需要注意的是,我们在使用浏览器时要注意版本是否一致,可以查看具体的帮助说明,如果不一致,即使程序能够运行,也会出现爬虫代理认证信息失败,需要弹窗要求手动输入认证信息的问题。