距离上次写爬虫文章已经过了许久了,之前写过一篇20行Python代码爬取王者荣耀全英雄皮肤 [1],反响强烈,其中有很多同学希望我再写一篇针对英雄联盟官网的皮肤爬取,但苦于事情繁多,便一拖再拖,一直拖到了现在,那么本篇文章我们就一起来学习一下如何爬取英雄联盟全英雄皮肤。

爬取代码非常简单,从上到下可能只需要写30行左右就能完成,但重要的是分析过程,在此之前,我们先来了解一下本篇文章需要用到的模块。

requests模块介绍

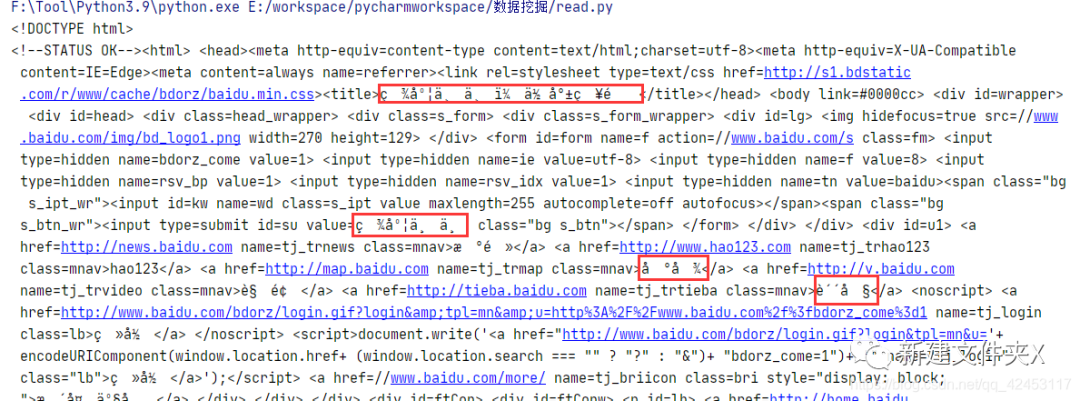

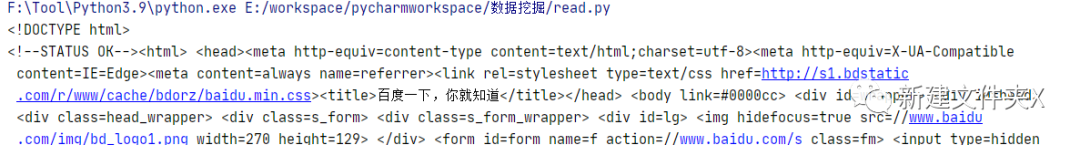

首先是requests模块,这是一个模拟浏览器请求的模块,我们可以通过它来获取网页上的信息,比如百度:

import requests

运行结果: 通过

通过get函数就能够向指定参数的url发送请求,得到的response对象中封装了很多响应的信息,其中的text即为响应内容,注意到获取的内容里有乱码,这是编解码不一致造成的,只需先获取二进制数据,然后重新解码即可:

import requests

运行结果:

json模块

json模块可以对json字符串和Python数据类型进行相互转换,比如将json转换为Python对象:

import json

使用loads函数即可将json字符串转为字典类型,运行结果:

<class 'dict'>

而若是想将Python数据转为json字符串,也非常简单:

import json

通过dumps函数即可将Python数据转为json字符串,运行结果:

<class 'str'>

准备工作

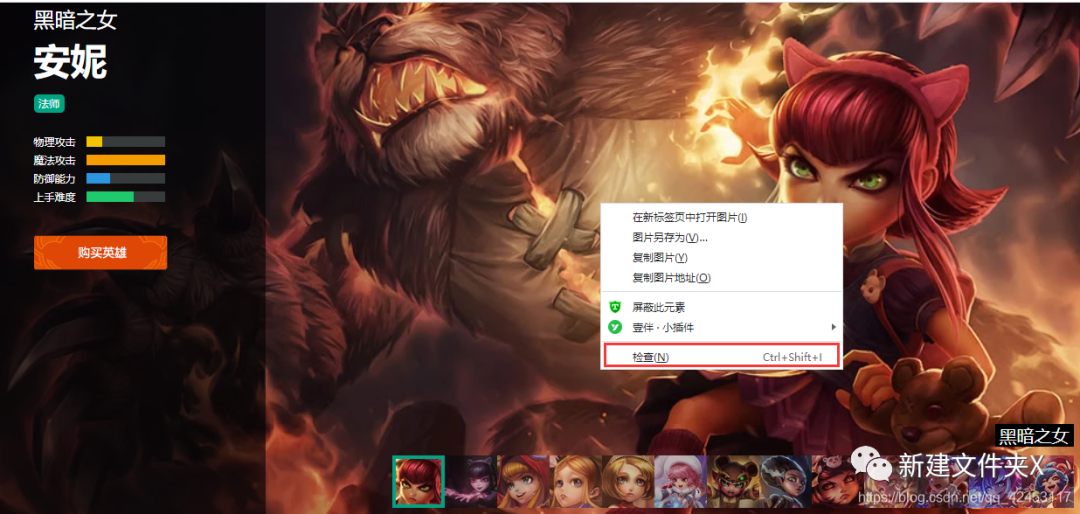

前面介绍了两个模块,通过这两个模块我们就能够完成这个程序了。在正式开始编写代码之前,我们首先需要分析数据来源,来到官网:https://lol.qq.com/main.shtml,往下拉找到英雄列表:我们随意点击一个英雄进去查看: 在皮肤图片上右键点击检查:

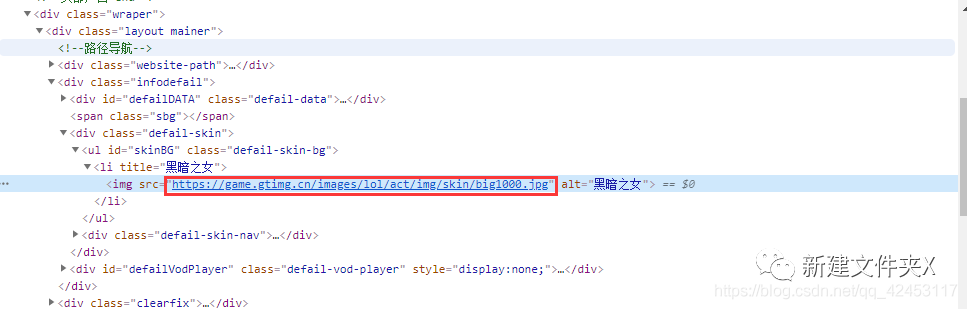

在皮肤图片上右键点击检查: 这样就找到了这个皮肤的url,我们再选择第二个皮肤,看看它的url:

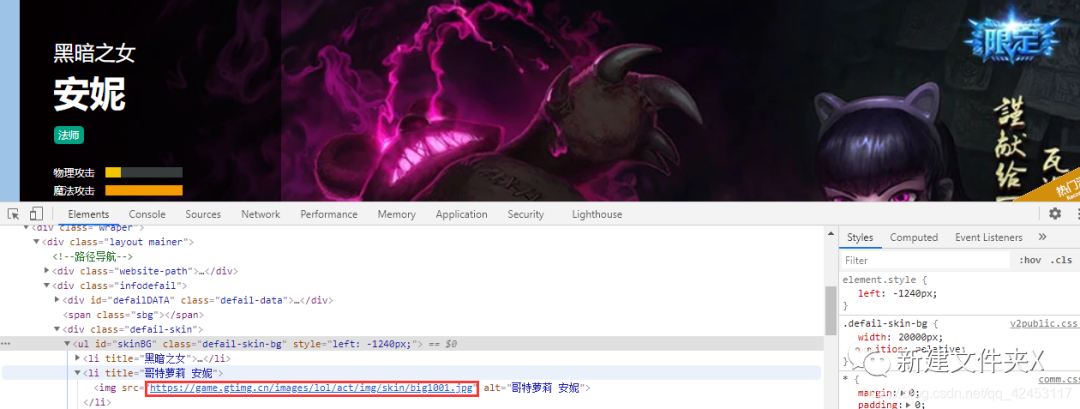

这样就找到了这个皮肤的url,我们再选择第二个皮肤,看看它的url: 我们将安妮所有皮肤的url全部拿出来看看:

我们将安妮所有皮肤的url全部拿出来看看:

https://game.gtimg.cn/images/lol/act/img/skin/big1000.jpg

从这些url中能发现什么规律呢?其实规律非常明显,url前面的内容都是一样的,唯一不同的是big1000.jpg,而每个皮肤图片就是在该url的基础上加1。

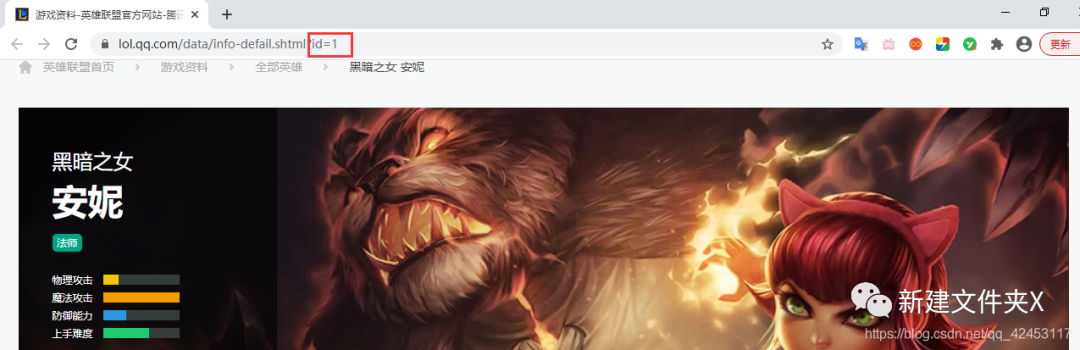

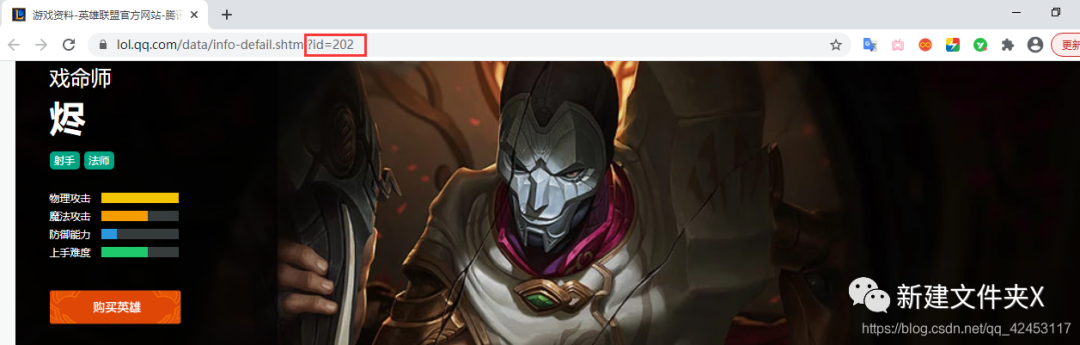

那么问题来了,它是如何区分这张图片所属的英雄的呢?我们观察浏览器上方的地址: 地址上有一个属性值id为1,那么我们可以猜测一下,皮肤图片url中的

地址上有一个属性值id为1,那么我们可以猜测一下,皮肤图片url中的big1000.jpg是不是由英雄id和皮肤id共同组成的呢?

要想证明我们的猜想,就必须再去看看其它英雄皮肤是不是也满足这一条件: 打开烬的详情页面,其id为202,由此,烬的皮肤图片url最后部分应为:

打开烬的详情页面,其id为202,由此,烬的皮肤图片url最后部分应为:big ' + 202 + ' 皮肤编号.jpg,所以其url应为:

https://game.gtimg.cn/images/lol/act/img/skin/big202000.jpg

事实是不是如此呢?检查一下便知: 规律已经找到,但是我们还面临着诸多问题,比如每个英雄对应的id是多少呢?每个英雄又分别有多少个皮肤呢?

规律已经找到,但是我们还面临着诸多问题,比如每个英雄对应的id是多少呢?每个英雄又分别有多少个皮肤呢?

查询英雄id

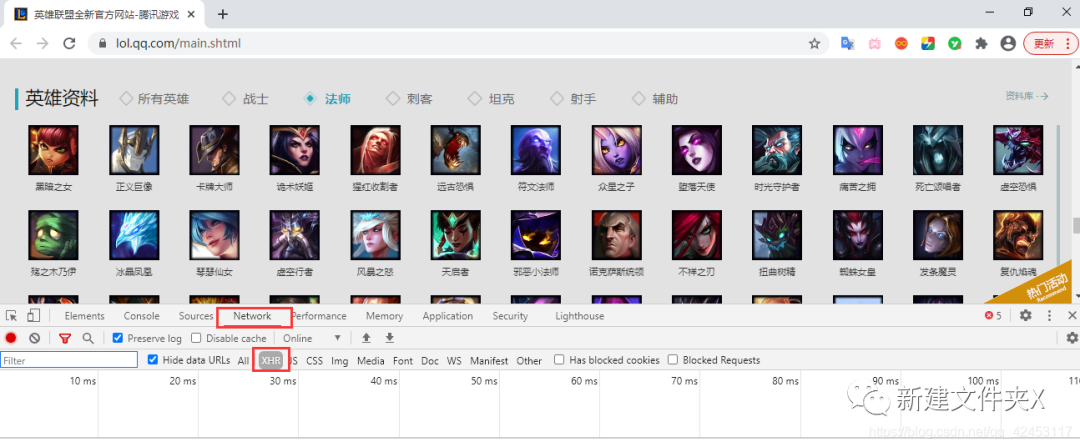

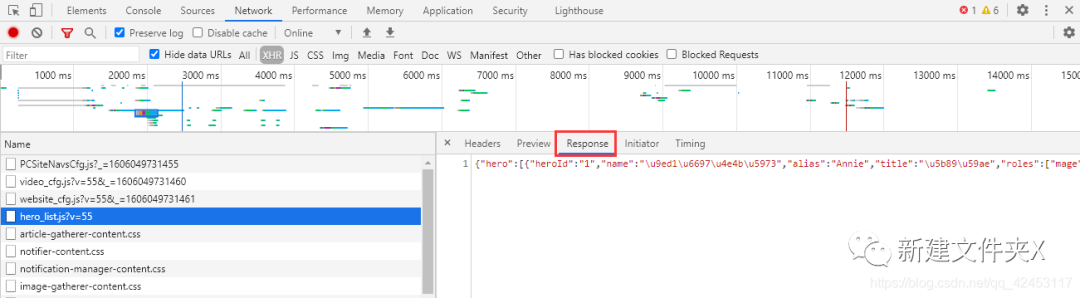

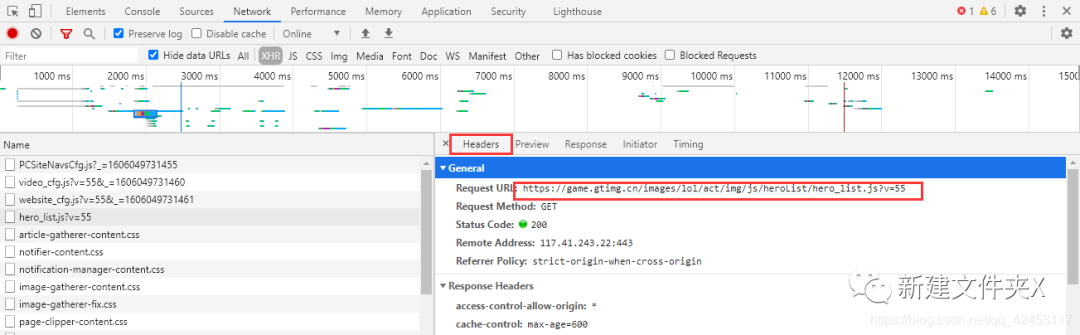

先来解决第一个问题,每个英雄对应的id是多少?我们只能从官网首页中找找线索,在首页位置打开网络调试台: 点击Network,并选中XHR,XHR是浏览器与服务器请求数据所依赖的对象,所以通过它便能筛选出一些服务器的响应数据。此时我们刷新页面,在筛选出的内容发现了这么一个东西:

点击Network,并选中XHR,XHR是浏览器与服务器请求数据所依赖的对象,所以通过它便能筛选出一些服务器的响应数据。此时我们刷新页面,在筛选出的内容发现了这么一个东西:

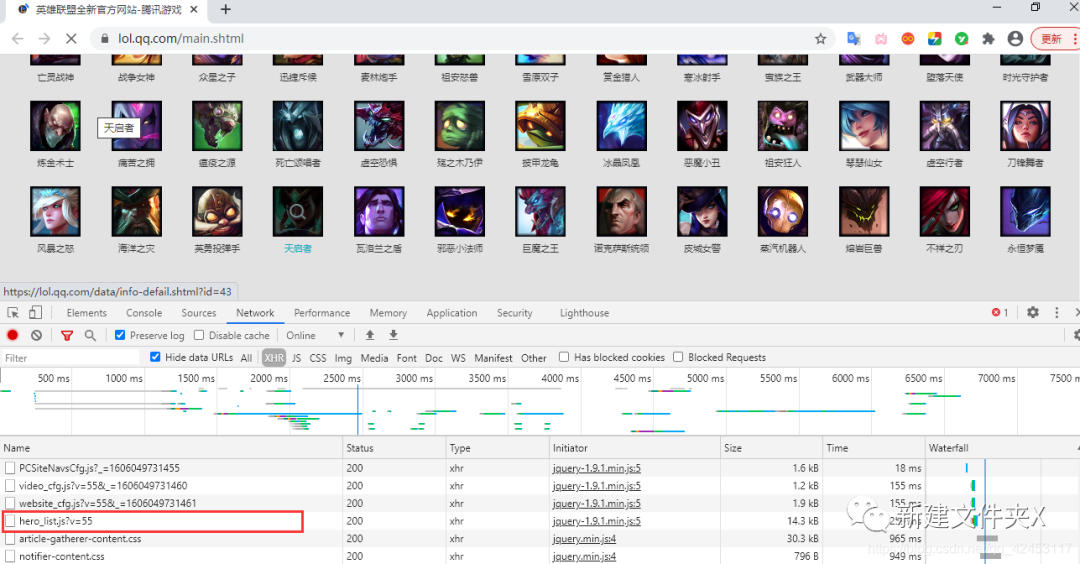

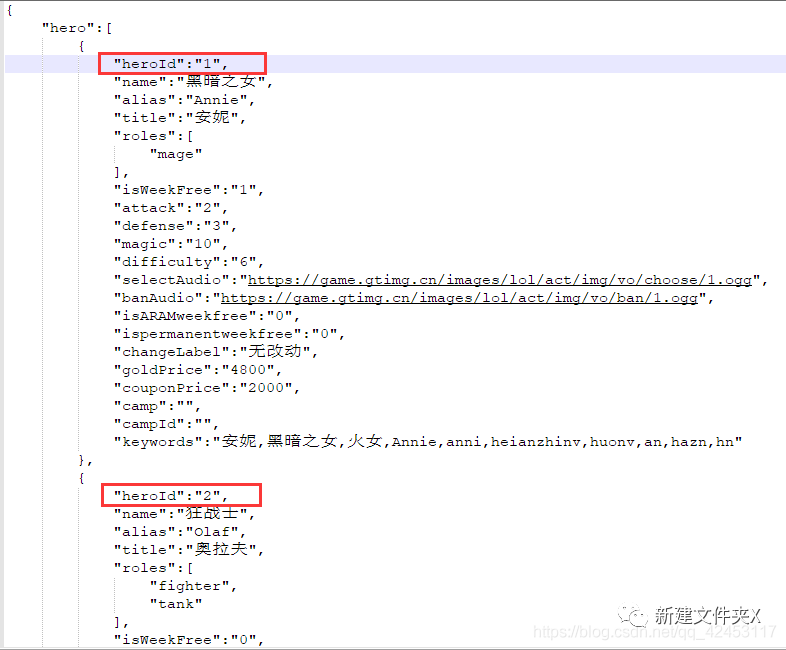

hero_list,英雄列表?这里面会不会存储着所有英雄的信息呢? 点击右侧的Response,得到了一串json字符串,我们将其解析一下:

点击右侧的Response,得到了一串json字符串,我们将其解析一下: 这些数据里果然存储的是英雄的信息,包括名字、id、介绍等等,那么接下来我们的任务就是将英雄名字和id单独提取出来,过滤掉其它信息。

这些数据里果然存储的是英雄的信息,包括名字、id、介绍等等,那么接下来我们的任务就是将英雄名字和id单独提取出来,过滤掉其它信息。

忘了告诉你们了,这个文件的url在这里可以找到: 接下来开始写代码:

接下来开始写代码:

import json

首先通过requests模块请求该url,就能够获取到一个json字符串,然后使用json模块将该字符串转为Python中的列表,最后循环取出每个英雄的name和heroid属性,放入新定义的列表中,这个程序就完成了英雄id的提取。

查询皮肤个数

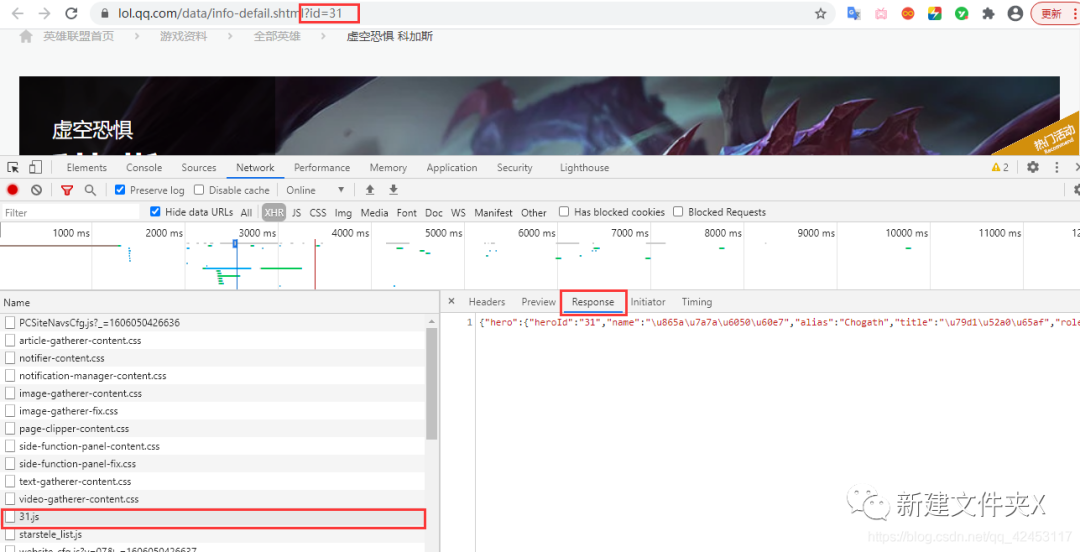

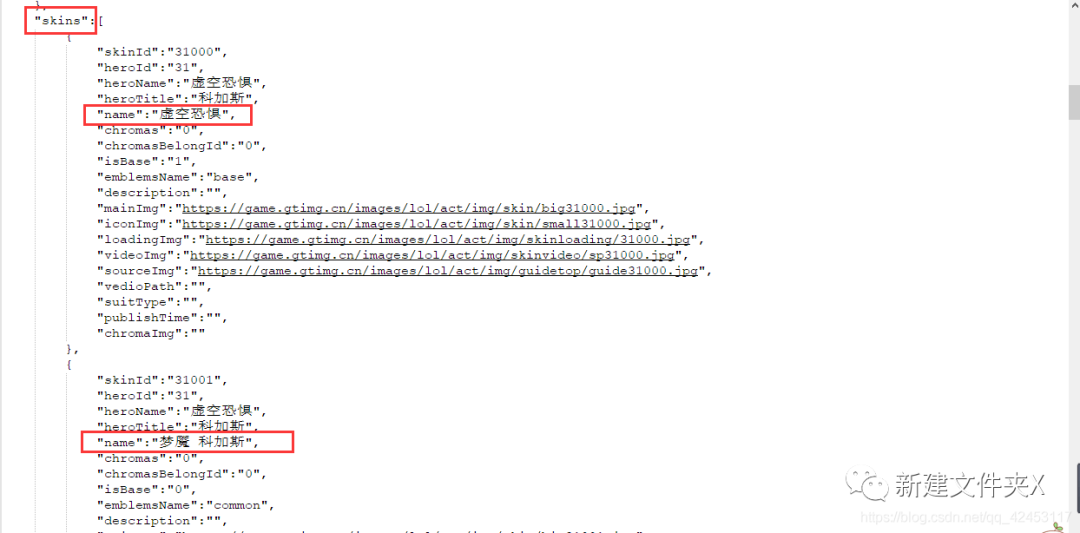

接下来解决第二个问题,如何知晓某个英雄究竟有多少个皮肤,按照刚才的思路,我们可以猜测一下,对于皮肤也应该会有一个文件存储着皮肤信息,在某个英雄的皮肤页面打开网络调试台,并选中XHR,刷新页面,找找线索: 找来找去确实找不到有哪个文件是跟皮肤有关系的,但是这里发现了一个31.js文件,而当前英雄的id也为31,这真的是巧合吗?我们将右边的json字符串解析一下:

找来找去确实找不到有哪个文件是跟皮肤有关系的,但是这里发现了一个31.js文件,而当前英雄的id也为31,这真的是巧合吗?我们将右边的json字符串解析一下: 该json数据中有一个skins属性,该属性值即为当前英雄的皮肤信息,既然找到了数据,那接下来就好办了,开始写代码:

该json数据中有一个skins属性,该属性值即为当前英雄的皮肤信息,既然找到了数据,那接下来就好办了,开始写代码:

import json

源程序实现

准备工作已经完成了我们所有的前置任务,接下来就是在此基础上编写代码了:

import requests

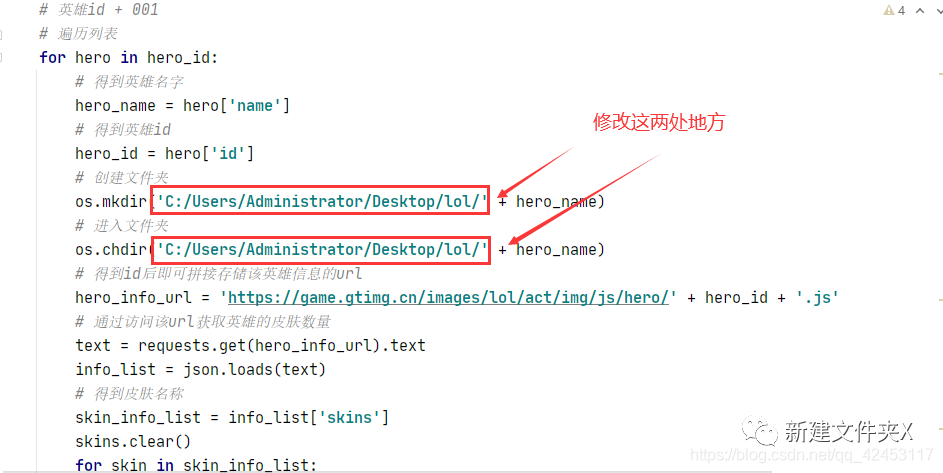

运行效果: 运行之前记得在桌面上创建一个lol文件夹,如果想改动的话也可以修改程序:

运行之前记得在桌面上创建一个lol文件夹,如果想改动的话也可以修改程序: 程序中还考虑到了一些其它情况,比如在爬取这个皮肤的时候会出现问题:

程序中还考虑到了一些其它情况,比如在爬取这个皮肤的时候会出现问题: 因为图片路径是以皮肤名字命名的,然而这个皮肤的名字中竟然有个

因为图片路径是以皮肤名字命名的,然而这个皮肤的名字中竟然有个/,它是会影响到我们的图片保存操作的,所以在保存前将斜杠替换成空字符即可。

还有一个问题就是即使是第一个皮肤,其编号也应该为000而不是0,所以还需要对其进行一个转化,让其始终是三位数。

最后

本篇文章同样继承了上篇文章精简的特点,抛去注释的话总共30行代码左右,程序当然还有一些其它地方可以进一步优化,这就交给大家自由发挥了。

文章代码已上传至GitHub:https://github.com/blizzawang/Spider\_LOL,有什么好的建议,欢迎Issues。

References

[1] 20行Python代码爬取王者荣耀全英雄皮肤 : https://blizzawang.blog.csdn.net/article/details/103190981

本文分享自微信公众号 - ZackSock(ZackSock)。

如有侵权,请联系 support@oschina.cn 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。