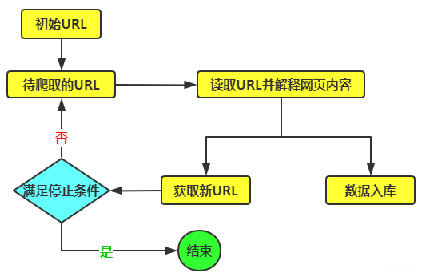

一、增量爬取的核心思想与优势 在深入代码之前,我们首先要理解增量爬取的核心理念。与传统的全量爬虫(每次运行都重新抓取所有数据)不同,增量爬虫只抓取自上次爬取以来新增或发生变化的数据。 其核心优势不言而喻: 极大提升效率:网络请求和数据处理的量级大幅下降,节省带宽和计算资源。 减轻目标网站压力:遵循了良好的爬虫礼仪,避免了不必要的重复请求,降低了IP被封禁的风险。 实现近实时监控:可以高频率地运行,从而更快地发现新的成交记录。 降低存储与处理成本:无需存储大量重复数据。 二、设计贝壳网增量爬取策略 要实现增量爬取,我们需要一个可靠的机制来识别“新数据”。对于贝壳网的成交数据,我们主要有两种策略: 基于列表页的发布时序识别:持续监控小区或区域的成交列表页,列表通常按成交时间倒序排列。我们记录下已爬取过的最大成交日期或特定ID,下次只抓取排在这个标记之前的“新”记录。 基于数据唯一标识符:每条成交记录很可能有一个唯一的ID(如 deal_id)。我们只需在本地维护一个已爬取ID的集合,新的爬取任务中,遇到已存在的ID即停止或跳过。 在实际应用中,策略一(基于时序)更为常用和可靠。因为列表页本身提供了时序信息,我们可以在不访问详情页的情况下就判断出新数据的范围,从而避免大量无效的详情页请求。 系统工作流设计: 初始化:首次运行,全量抓取当前列表页的所有数据,并记录下“最新成交日期”作为基准点。 增量循环: a. 请求列表页,按成交日期倒序排列。 b. 逐条解析列表项中的成交日期(和ID)。 c. 将解析到的日期与本地记录的“最新成交日期”进行比较。 d. 如果日期新于基准点,则抓取该条记录的详情,并更新本地“最新成交日期”。 e. 如果日期等于或旧于基准点,则停止当前页的抓取(因为更早的数据我们已经有了)。 持久化基准点:将每次爬取后最新的日期保存到文件或数据库中,供下次爬取使用。 三、技术实现:代码实战 我们将使用 requests 发送请求,BeautifulSoup 解析HTML,并使用 SQLite 数据库进行数据存储和状态管理。 核心代码实现 以下是完整的增量爬虫示例代码,包含了详细的注释。

time.sleep(1)

# 如果本页发现了新数据,并且没有触发停止,则可能还有下一页

next_signal = 'continue' if new_data_found else 'stop'

return next_signal, current_page_latest_date

except requests.RequestException as e:

print(f"请求列表页第{page_num}页失败: {e}")

return 'stop', saved_latest_date

def parse_detail_page(self, detail_url, deal_id):

"""解析详情页,提取详细的成交信息"""

try:

response = self.session.get(detail_url, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'lxml')

# **以下选择器为示例,请根据贝壳网实际HTML结构进行调整!**

title = soup.find('title').text if soup.find('title') else 'N/A'

total_price_el = soup.find('span', class_='total')

total_price = float(total_price_el.text.strip()) if total_price_el else 0.0

unit_price_el = soup.find('span', class_='unitPriceValue')

unit_price = float(unit_price_el.text.strip()) if unit_price_el else 0.0

# 房屋信息可能需要组合多个字段

house_info_el = soup.find('div', class_='houseInfo')

house_info = house_info_el.text.strip() if house_info_el else 'N/A'

# 从列表页传递过来的日期可能更可靠

deal_date_el = soup.find('span', text=re.compile('成交日期'))

deal_date = deal_date_el.find_next('span').text.strip() if deal_date_el else None

return {

'deal_id': deal_id,

'title': title,

'deal_date': deal_date,

'total_price': total_price,

'unit_price': unit_price,

'house_info': house_info

}

except Exception as e:

print(f"解析详情页 {detail_url} 失败: {e}")

return None

def save_to_database(self, deal_data):

"""将成交数据存入数据库"""

conn = sqlite3.connect(self.db_path)

cursor = conn.cursor()

try:

cursor.execute('''

INSERT OR IGNORE INTO deal_records

(deal_id, title, deal_date, total_price, unit_price, house_info)

VALUES (?, ?, ?, ?, ?, ?)

''', (

deal_data['deal_id'],

deal_data['title'],

deal_data['deal_date'],

deal_data['total_price'],

deal_data['unit_price'],

deal_data['house_info']

))

conn.commit()

print(f"成功保存成交记录: {deal_data['deal_id']}")

except sqlite3.Error as e:

print(f"保存数据到数据库失败: {e}")

finally:

conn.close()

def run(self, max_pages=5):

"""启动增量爬虫"""

print("启动贝壳网增量爬虫...")

latest_date_in_this_run = self._get_saved_latest_date()

for page in range(1, max_pages + 1):

print(f"\n正在解析第 {page} 页...")

signal, page_latest_date = self.parse_list_page(page)

# 更新本次运行中遇到的最新日期

if page_latest_date > latest_date_in_this_run:

latest_date_in_this_run = page_latest_date

# 根据返回的信号决定是否继续翻页

if signal == 'stop':

print("已无新数据,爬取结束。")

break

# 如果已经是最后一页,也结束

if page == max_pages:

print("已达到最大翻页数,爬取结束。")

# 运行结束后,更新状态表中的最新日期

if latest_date_in_this_run != self._get_saved_latest_date():

self._update_saved_latest_date(latest_date_in_this_run)

else:

print("本次爬取未发现更新日期数据。")

if __name__ == '__main__':

spider = BeikeIncrementalSpider()

spider.run(max_pages=3) # 首次运行可尝试3页,后续运行1页即可四、策略优化与注意事项 HTML结构变动:网页结构会随时变化,代码中的CSS选择器需要定期检查和更新。 反爬虫机制:贝壳网有完善的反爬措施。除了设置User-Agent,你还需要考虑: IP代理池:应对IP频率限制。例如:https://www.16yun.cn/ 请求速率控制:在请求间加入随机延时(如 time.sleep(random.uniform(1, 3)))。 Cookie处理:维护会话状态。 数据去重:除了基于日期,结合 deal_id 进行唯一性约束是更保险的做法。 定时任务:使用系统的 crontab (Linux/macOS) 或 计划任务 (Windows) 来定时执行这个爬虫脚本(例如,每天凌晨执行一次),实现完全自动化的监控。 伦理与合规:务必遵守 robots.txt,控制爬取频率,仅将数据用于个人分析或研究,避免对目标网站造成负担,并严格遵守相关法律法规和数据使用协议。 结语 通过本文介绍的增量爬取策略,我们成功构建了一个能够持续、高效监控贝壳网最新成交数据的系统。这个系统不再是一个简单的“一次性”脚本,而是一个能够长期运行、自我更新的数据管道。它将数据获取的成本降至最低,同时将数据的时效性价值最大化。掌握了这项技术,你就拥有了在瞬息万变的房地产市场中发现先机的“火眼金睛”。